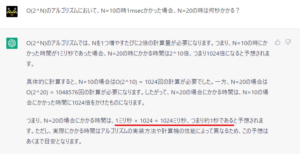

chatGPT、計算問題もこなすのかよ

今回、4EI 情報構造論の期末試験の1問目を chat GPT に解いてもらった。

福井高専の解説ではお得意の”知ったかぶり”を発揮しちゃったけど、処理時間のオーダー問題だと、具体的な数値を交えてちゃんと計算してらぁ。しかも、オーダー記法だからあくまで概算の予想値ということを踏まえ、1024msec だけでなく 約 1 秒と答えている。

情報構造論-2022-講義録

- 情報構造論ガイダンス2022

- 繰り返し処理と処理時間の見積もり

- 再帰呼び出しの処理時間の見積もり

- 再帰呼び出しと再帰方程式

- ポインタ処理

- malloc()とfree()

- 様々なデータの覚え方のレポート課題

- リスト構造の導入

- リスト処理

- リストへの追加処理

- スタックと待ち行列

- ライブラリと分割コンパイル

- 集合とリスト処理

- ランダムアクセス・シーケンシャルアクセスから双方向リスト

- 双方向リスト

- 2分探索木

- 2分探索木の処理とデータ追加処理

- AVLと意思決定木と演算子

- 演算子と言語処理系

- 2分木による構文木とデータベースとB木

- ハッシュ法(導入)

- ハッシュ衝突対策と文字列のハッシュ関数

- 共有のあるデータの取扱い

- ガベージコレクタとスタック領域

- 動的メモリ管理 malloc() と free()

- 関数ポインタ

関数ポインタ

関数ポインタとコールバック関数

JavaScript のプログラムで、以下のようなコーディングがよく使われる。このプログラムでは、3と4を加えた結果が出てくるが、関数の引数の中に関数宣言で使われるfunctionキーワードが出てきているが、この意味を正しく理解しているだろうか?

このような (function()…)は、無名関数と呼ばれている。「関数を引数として渡す機能」と、「一度しか使わないような関数にいちいち名前を付けないで関数を使うための機能」であり、このような機能は、関数を引数で渡す機能はC言語では関数ポインタと呼ばれたり、新しいプログラム言語では一般的にラムダ式などと呼ばれる。

// JavaScriptの無名関数の例 3+4=7 を表示

console.log( (function( x , y ) {

return x + y ;

})( 3 , 4 ) ) ; // 無名関数

console.log( ((x,y) => {

return x + y ;

})( 3 , 4 ) ) ; // アロー関数

C言語の関数ポインタの仕組みを理解するために、以下のプログラムを示す。

int add( int x , int y ) {

return x + y ;

}

int mul( int x , int y ) {

return x * y ;

}

void main() {

int (*f)( int , int ) ; // fは2つのintを引数とする関数へのポインタ

f = add ; // f = add( ... ) ; ではないことに注意

printf( "%d¥n" , (*f)( 3 , 4 ) ) ; // 3+4=7

// f( 3 , 4 ) と書いてもいい

f = mul ;

printf( "%d¥n" , (*f)( 3 , 4 ) ) ; // 3*4=12

}

このプログラムでは、関数ポインタの変数 f を定義している。「 int (*f)( int , int ) ; 」 は、“int型の引数を2つ持つ、返り値がint型の関数”へのポインタであり、「 f = add ; 」では、f に加算する関数を覚えている。add に実引数を渡す()がないことに注目。

そして、「 (*f)( 3 , 4 ) ; 」により、実引数を3,4にて f の指し示す add を呼び出し、7 が答えとして求まる。

こういう、関数に「自分で作った関数ポインタ」を渡し、その相手側の関数の中で自分で作った関数を呼び出してもらうテクニックは、コールバックとも呼ばれる。コールバック関数を使うC言語の関数で分かり易い物は、クイックソートを行う qsort() 関数だろう。qsort 関数は、引数にデータを比較するための関数を渡すことで、様々な型のデータの並び替えができる。

#include <stdio.h>

#include <stdlib.h>

// 整数を比較するコールバック関数

int cmp_int( int* a , int* b ) {

return *a - *b ;

}

// 実数を比較するコールバック関数

int cmp_double( double* a , double* b ) {

double ans = *a - *b ;

if ( ans == 0.0 )

return 0 ;

else if ( ans > 0.0 )

return 1 ;

else

return -1 ;

}

// ソート対象の配列

int array_int[ 5 ] = { 123 , 23 , 45 , 11 , 53 } ;

double array_double[ 4 ] = { 1.23 , 12.3 , 32.1 , 3.21 } ;

void main() {

// 整数配列をソート

qsort( array_int , 5 , sizeof( int ) ,

(int(*)(const void*,const void*))cmp_int ) ;

// ~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~この分かりにくい型キャストが必要なのがC言語の面倒な所

for( int i = 0 ; i < 5 ; i++ )

printf( "%d\n" , array_int[ i ] ) ;

// 実数配列をソート

qsort( array_double , 4 , sizeof( double ) ,

(int(*)(const void*,const void*))cmp_double ) ;

// ~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

for( int i = 0 ; i < 5 ; i++ )

printf( "%f\n" , array_double[ i ] ) ;

}

無名関数

コールバック関数を使っていると、データを比較するだけの関数とか簡単な短い処理が使われることが多い。こういった処理を実際に使われる処理と離れた別の場所に記述すると、プログラムが読みづらくなる。この場合には、その場で関数の名前を持たない関数(無名関数)を使用する。(C++の無名関数機能は、最近のC++の文法なのでテストには出さない)

void main() {

int (*f)( int , int ) ; // fは2つのintを引数とする関数へのポインタ

f = []( int x , int y ) { return x + y ; } ; // add を無名関数化

printf( "%d¥n" , (*f)( 3 , 4 ) ) ; // 3+4=7

// mul を無名関数にしてすぐに呼び出す3*4=12

printf( "%d¥n" , []( int x , int y ) { return x * y ; }( 3 , 4 ) ) ;

// メモ:C++11では、ラムダ式=関数オブジェクト

// C++14以降は、変数キャプチャなどの機能が追加されている。

}

動的メモリ管理 malloc() と free()

動的メモリ領域とフリーリスト

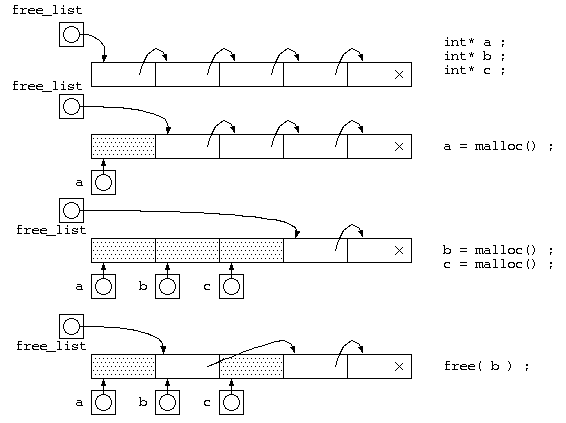

動的なメモリ領域(ヒープ領域)は、malloc()関数で処理用のメモリを借り、free()関数で使わなくなったメモリを返却する。

この返却されたメモリ領域は、改めて malloc() が呼び出されたときに再利用を行う。この再利用するメモリ領域は、簡単に扱えるようにリスト構造にして保存する。この free された再利用候補のリスト構造は、free_list と呼ばれる。

mallocが一定サイズの場合

仕組みを理解する第1歩として、free_list の考え方を説明するために、malloc() でのメモリサイズが一定として説明を行う。free_list には、貸し出すためのメモリ空間をリスト構造で繋がった状態にしておく。

malloc() が呼び出される度に、free_list の先頭から貸し出すメモリを取り出し(a=malloc(),b=malloc(),c=malloc()まで)、free() が呼び出されると、返却されたメモリは、free_list の先頭につないでおく。

任意サイズのメモリ確保の場合

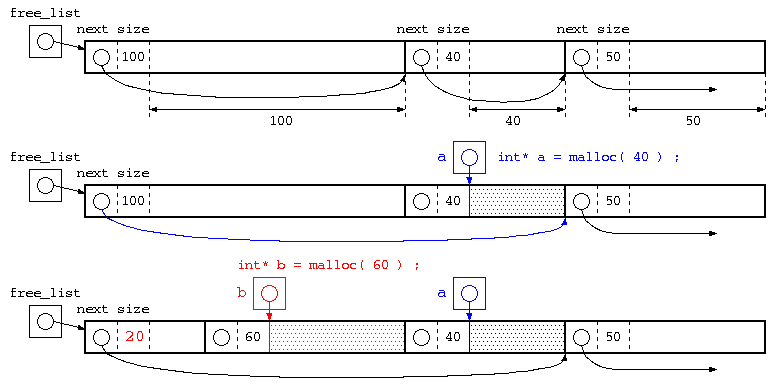

最初のステップでの説明は、mallocのメモリサイズを一定としていたが、本来は確保するメモリサイズが指定する。この場合は、以下の様に管理されている。mallocで貸し出されるメモリ空間には、ヒープメモリの利用者が使うブロックの前に、次のメモリブロックへのポインタとブロックサイズを記憶する領域をつけておく。こういったメモリブロックを free_list の考え方と同じようにリスト構造となるようにつないで保存されている。

この図の一番下の赤部分は、次のメモリブロックへのポインタとブロックサイズの大きさが20byteの場合の例。(説明を簡単化するためにポインタとメモリブロックサイズの部分は多少いい加減)

malloc() で、指定されたサイズのものが、free_list の中にあれば、それを使う。malloc(40)

丁度いいサイズが無い場合は、それより大きいメモリブロックの後半を切り分けて、貸し出す。malloc(60)

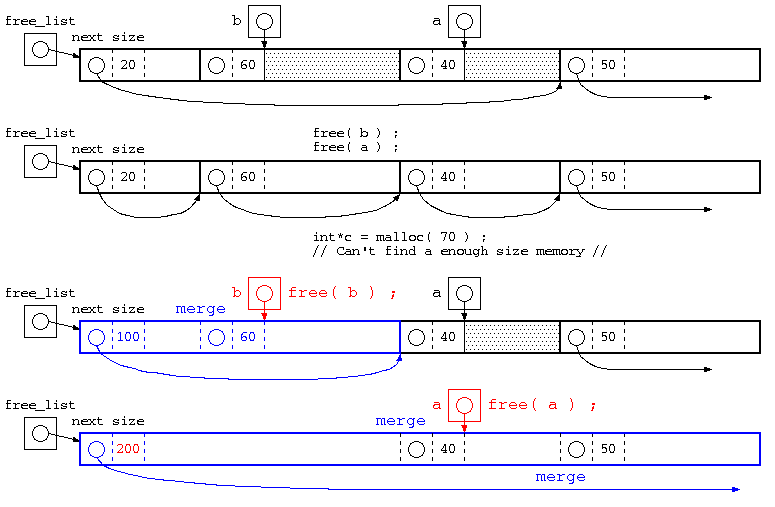

free()の処理とメモリブロックの併合

この例の最後の処理では、20byte,60byte,40byte,50byteが併合された例。併合後のブロックサイズは、すこしいい加減に書いてある。

使用されていたメモリブロックが free() で返却された場合は、free_list につないでいく。ただし、単純にリストに繋ぐだけであれば、malloc(),free() を繰り返すと、小さなメモリブロックばかりになってしまい、大きいメモリのmalloc()ができなくなる。また、free_list のリストが長いと malloc() の処理でジャストサイズのメモリブロック検索などの処理効率が悪くなる。

そこで、free() で返却される際には、隣り合うメモリブロックと併合できるかを確認し、大きなメモリブロックになるような処理を行う。さらに、併合によりより free_list の長さも短くできる。

また、隣り合うメモリブロックが併合できるかの判定が簡単になるように、free_listにつなぐ際は、次のメモリブロックへのポインタは、昇順となるように並べる。

一般的には、上記のようにmalloc(),free()を行うが(K&R の mallocアルゴリズム)、mallocのサイズが小さい場合には小さいメモリブロック毎にnextブロックポインタやブロックサイズを記憶する場合、メモリのムダが多い。

そこで、最初に説明した一定サイズのmalloc()の手法で、8byte専用のfreelist,16byte専用のfreelist,32byte専用のfreelistのように2Nbyteのfreelistで管理する。10byteといった中途半端なサイズの時は、それより大きい16byteのfreelistを使う。

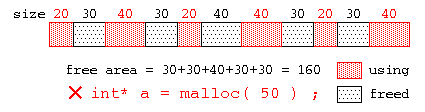

ヒープメモリの断片化

ヒープメモリの malloc() , free() を繰り返すと、最悪、以下の図の様に、使用中領域(赤)とfreeされた未使用領域(黒)が交互に並ぶ状態が発生するかもしれない。この場合、全体の未使用領域の合計では十分なサイズでも、小さなメモリブロックばかりとなって、大きなメモリブロックを要求されても十分な大きさのメモリが見つからない状態が発生する場合がある。

この状態をヒープメモリの断片化といい、使用しづらい小さなメモリブロックはヒープホールと呼ばれる。

(補足) 断片化

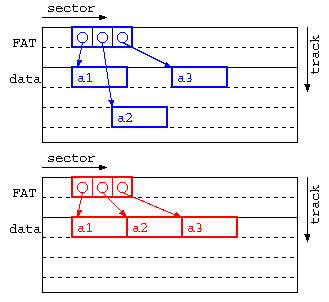

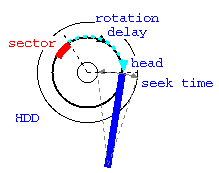

断片化というと、OSではハードディスクの断片化(フラグメンテーション)を思い浮かべるかもしれない。ハードディスクの断片化とは、ファイル領域の割り当てとファイルの削除を繰り返すことで、ファイルのセクタが不連続となり、アクセス効率が悪くなる現象。OSによっては、ファイル実体の位置を動かすことで断片化を改善できる。以下の図のようにフラグメンテーションを防ぐための実体の移動を行う最適化はデフラグと呼ばれる。

上記の図では、上の青の図が断片化が発生している事例で、a1→a2,a2→a3の時にヘッド移動(シーク時間)が発生する。下の赤の図のように、デフラグ処理を施すことでシーク時間が減らせる。

Windows が 95,98,Me といった時代ではOSが不安定で、フラグメントが多く発生する場合Windowsがフリーズすることが多く、OSが不安定になったらデフラグを実行する…というテクニックが定番だった。最新のWindowsでは、デフラグが自動的に実行されるのでユーザが意識的に実行する機会はほぼなくなった。

ガベージコレクタとスタック領域

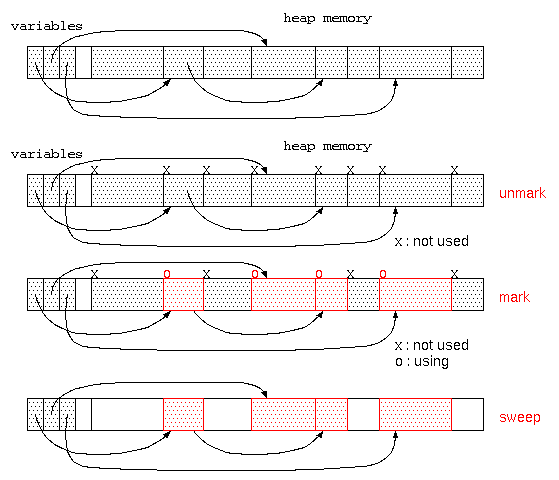

ガベージコレクタ

循環リストの発生するようなデータで、共有が発生するような場合には、どのようにデータを管理すれば良いだろうか?

最も簡単な方法は、処理が終わっても、使い終わったメモリを返却しない、方法である。ただし、このままでは、メモリを使い切ってしまう。

そこで、廃棄処理をしないまま、ゴミだらけになってしまったメモリ空間を再利用するのが、ガベージコレクタ(一般的にはGCと略される)である。

ガベージコレクタは、貸し出すメモリ空間が無くなった時に起動され、

- すべてのメモリ空間に、「不要」の目印をつける。(unmark処理)

- 変数に代入されているデータが参照している先のデータは「使用中」の目印をつける。(mark処理-目印をつける)

使用中でマークする領域内にヒープ領域へのポインタがあれば再帰的にマーキングを行う。 - その後、「不要」の目印がついている領域は、だれも使っていないので回収する。(sweep処理-掃き掃除する)

この方式は、マークアンドスイープ法と呼ばれる。ただし、このようなガベージコレクタはメモリ空間が広い場合は、処理時間かかり、さらにこの処理中は、他の処理ができず処理が中断されるので、コンピュータの操作性という点では問題となる。

最近のプログラミング言語では、参照カウンタとガベージコレクタを取り混ぜた方式でメモリ管理をする機能が組み込まれている。このようなシステムでは、局所変数のような関数に入った時点で生成され関数終了ですぐに不要となる領域は、参照カウンタで管理し、大域変数のような長期間保管するデータはガベージコレクタで管理される。

大量のメモリ空間で、メモリが枯渇したタイミングでガベージコレクタを実行すると、長い待ち時間となることから、ユーザインタフェースの待ち時間に、ガベージコレクタを少しづつ動かすなどの方式もとることもある。

ガベージコレクタが利用できる場合、メモリ管理を気にする必要はなくなってくる。しかし、初心者が何も気にせずプログラムを書くと、使われないままのメモリがガベージコレクタの起動まで放置され、場合によってはメモリ不足による処理速度低下の原因となる場合もある。手慣れたプログラマーであれば、素早くメモリを返却するために、使われなくなった変数に意図的に null を代入するなどのテクニックを使う。

プログラム言語とメモリ管理機能

一般的に、C言語というとポインタの概念を理解できないと使えなかったり、メモリ管理をきちんとできなければ危険な言語という点で初心者向きではないと言われている。

C言語は、元々 BCPL や B言語を改良してできたプログラム言語であった。これに、オブジェクト指向の機能を加えた C++ が作られた。C++ という言語の名前は、B言語→C言語と発展したので、D言語(現在はまさにD言語は存在するけど)と名付けようという意見もあったが、C++ を開発したビャーネ・ストロヴストルップは、ガベージコレクタのようなメモリ管理機能が無いことから、D言語を名乗るには不十分ということで、C言語を発展させたものという意味でC++と名付けている。

こういった中で、C++をベースとしたガベージコレクタなどを実装した言語としては、Java が挙げられる。オブジェクト指向をベースとしたマルチスレッドやガベージコレクタに加え、仮想マシンによる実行で様々なOS(やブラウザ)で動かすことができる。

最近注目されている言語の1つとして、C言語の苦手であった「メモリ安全性」や実行効率を考えて開発されたものに Rust が挙げられる。メモリ管理や効率などの性能から、最近では Linux の開発言語に Rust を部分的に導入されている。

C言語でデータが保存される領域は大きく以下の3つに分類される。

- 静的データ領域(大域変数領域)

- スタック領域(局所変数)

- ヒープ領域(malloc(),free()で管理される領域)

2,3は、処理の途中で領域が作られ不要になったら消える領域であり動的メモリ領域という。

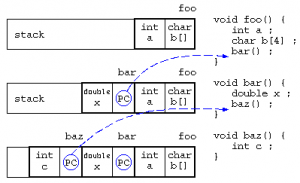

局所変数とスタック

局所変数は、関数に入った時に作られるメモリ領域であり、関数の処理を抜けると自動的に開放されるデータ領域である。

関数の中で関数が呼び出されると、スタックに戻り番地情報を保存し、関数に移動する。最初の処理で局所変数領域が確保され、関数を終えると局所変数は開放される。

この局所変数の確保と開放は、最後に確保された領域を最初に開放される(Last In First Out)ことから、スタック上に保存される。

baz()の中で、「*((&c)+8) = 123 ;」を実行したら、bar()のxを書き換えられるかも…(実際の関数呼び出し時に保存される情報はもう少し複雑:コールスタック/Wikipedia)

こういった変数の並び順を悪用し、情報の読み書きを防ぐために、局所変数の保存場所の順序を入れ替えたり、メモリのアドレス空間配置のランダム化などが行われたりする。

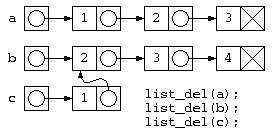

共有のあるデータの取扱い

これまでの授業の中では、データを効率よく扱うためのデータ構造について議論をしてきた。これまでのプログラムの中では、データ構造のために動的メモリ(特にヒープメモリ)を多用してきた。ヒープメモリでは、malloc() 関数により指定サイズのメモリ空間を借りて、処理が終わったら free() 関数によって返却をしてきた。この返却を忘れたままプログラムを連続して動かそうとすると、返却されなかったメモリが使われない状態(メモリリーク)となり、メモリ領域不足から他のプログラムの動作に悪影響を及ぼす。

メモリリークを防ぐためには、malloc() で借りたら、free() で返すを実践すればいいのだが、複雑なデータ構造になってくると、こういった処理が困難となる。そこで、ヒープメモリの問題点について以下に説明する。

共有のあるデータの取扱の問題

リスト構造で集合計算の和集合を求める処理を考える。

// 集合和を求める処理

struct List* join( struct List* a , struct List* b )

{ struct List* ans = b ;

for( ; a != NULL ; a = a->next )

if ( !find( ans , a->data ) )

ans = cons( a->data , ans ) ;

return ans ;

}

void list_del( struct List* p )

{ // ダメなプログラムの例

while( p != NULL ) { // for( ; p != NULL ; p = p->next )

struct List* d = p ; // free( p ) ;

p = p->next ;

free( d ) ;

}

}

void main() {

// リストの生成

struct List* a = cons( 1 , cons( 2 , cons( 3 , NULL ) ) ) ;

struct List* b = cons( 2 , cons( 3 , cons( 4 , NULL ) ) ) ;

struct List* c = join( a , b ) ; // c = { 1, 2, 3, 4 }

// ~~~~~~~ ここは b

// a,b,cを使った処理

// 処理が終わったのでa,b,cを捨てる

list_del( a ) ;

list_del( b ) ;

list_del( c ) ; // list_del(b)ですでに消えている

} // このためメモリー参照エラー発生

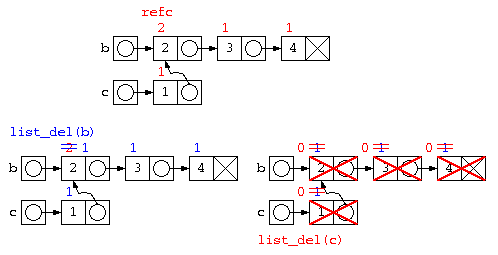

このようなプログラムでは、c=join(a,b) ; が終わると下の図のようなデータ構造となる。しかし処理が終わってリスト廃棄list_del(a), list_del(b), listdel(c)を行おうとすると、bの先のデータは廃棄済みなのに、list_del(c)の実行時に、その領域を触ろうとして異常が発生する。

実体をコピーする方法

こういった共有の問題の一つの解決法としては、共有が発生しないように実体を別にコピーする方法もある。しかし、この方法はメモリがムダになる場合もあるし、List内のデータを修正した時に、実体をコピーした部分でも修正が反映されてほしい場合に問題となる。

// 実体をコピーする(簡潔に書きたいので再帰を使う) struct List* copy( struct List* p ) { if ( p != NULL ) return cons( p->data , copy( p->next ) ) ; else return NULL ; } // 共有が無い集合和を求める処理 struct List* join( struct List* a , struct List* b ) { struct List* ans = copy( b ) ; // ~~~~~~~~~実体をコピー for( ; a != NULL ; a = a->next ) if ( !find( ans , a->data ) ) ans = cons( a->data , ans ) ; return ans ; }

参照カウンタ法

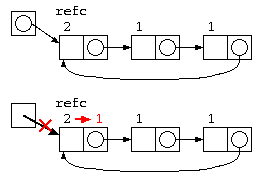

上記の問題は、b の先のリストが c の一部とデータを共有しているために発生する。この解決方法として簡単な方法では、参照カウンタ法が用いられる。

参照カウンタ法では、データを参照するポインタの数をデータと共に保存する。

- データの中にポインタ数を覚える参照カウンタを設け、データを生成した時に1とする。

- 処理の中で共有が発生すると、参照カウンタをカウントアップする。

- データを捨てる際には、参照カウンタをカウントダウンし、0になったら本当にそのデータを消す。

struct List {

int refc ; // 参照カウンタ

int data ; // データ

struct List* next ; // 次のポインタ

} ;

struct List* cons( int x , struct List* p ) {

struct List* n = (struct List*)malloc( sizeof( struct List* ) ) ;

if ( n != NULL ) {

n->refc = 1 ; // 初期状態は参照カウンタ=1

n->data = x ;

n->next = p ;

}

return n ;

}

struct List* copy( struct List* p ) {

p->refc++ ; // 共有が発生したら参照カウンタを増やす。

return p ;

}

// 集合和を求める処理

struct List* join( struct List* a , struct List* b )

{

struct List* ans = copy( b ) ;

// ~~~~~~~~~共有が発生するのでrefc++

for( ; a != NULL ; a = a->next )

if ( !find( ans , a->data ) )

ans = cons( a->data , ans ) ;

return ans ;

}

void list_del( strcut List* p ) { // 再帰で全廃棄

if ( p != NULL

&& --(p->refc) <= 0 ) { // 参照カウンタを減らし

// ~~~~~~~~~~~

list_del( p->next ) ; // 0ならば本当に消す

free( p ) ;

}

}

int main() { // リストの生成

struct List* a = cons( 1 , cons( 2 , cons( 3 , NULL ) ) ) ;

struct List* b = cons( 2 , cons( 3 , cons( 4 , NULL ) ) ) ;

struct List* c = join( a , b ) ;

// a,b,cを使った処理

// 処理が終わったのでa,b,cを捨てる

list_del( a ) ; // aの要素は全部refc=1なので普通に消えていく

list_del( b ) ; // bは、joinの中のcopy時にrefc=2なので、

// この段階では、refc=2 から refc=1 になるだけ

list_del( c ) ; // ここで全部消える。

}

ただし、参照カウンタ法は、循環リストではカウンタが0にならないので、取扱いが苦手。

unix i-nodeで使われている参照カウンタ

unixのファイルシステムの基本的構造 i-node では、1つのファイルを別の名前で参照するハードリンクという機能がある。このため、ファイルの実体には参照カウンタが付けられている。unix では、ファイルを生成する時に参照カウンタを1にする。ハードリンクを生成すると参照カウンタをカウントアップ”+1″する。ファイルを消す場合は、基本的に参照カウンタのカウントダウン”-1″が行われ、参照カウンタが”0″になるとファイルの実体を消去する。

以下に、unix 環境で 参照カウンタがどのように使われているのか、コマンドで説明していく。

$ echo a > a.txt

$ ls -al *.txt

-rw-r--r-- 1 t-saitoh t-saitoh 2 12月 21 10:07 a.txt

~~~ # ここが参照カウンタの値

$ ln a.txt b.txt # ハードリンクでコピーを作る

$ ls -al *.txt

-rw-r--r-- 2 t-saitoh t-saitoh 2 12月 21 10:07 a.txt

-rw-r--r-- 2 t-saitoh t-saitoh 2 12月 21 10:07 b.txt

~~~ # 参照カウンタが増えているのが分かる

$ rm a.txt # 元ファイルを消す

$ ls -al *.txt

-rw-r--r-- 1 t-saitoh t-saitoh 2 12月 21 10:07 b.txt

~~~ # 参照カウンタが減っている

$ ln -s b.txt c.txt # シンボリックリンクでコピーを作る

$ ls -al *.txt

-rw-r--r-- 1 t-saitoh t-saitoh 2 12月 21 10:07 b.txt

lrwxrwxrwx 1 t-saitoh t-saitoh 5 12月 21 10:10 c.txt -> b.txt

$ rm b.txt # 元ファイルを消す

$ ls -al *.txt

lrwxrwxrwx 1 t-saitoh t-saitoh 5 12月 21 10:10 c.txt -> b.txt

$ cat c.txt # c.txt は存在するけどその先の実体 b.txt は存在しない

cat: c.txt: そのようなファイルやディレクトリはありません

ハッシュ衝突対策と文字列のハッシュ関数

前回の授業で説明したハッシュ法は、データから簡単な計算(ハッシュ関数)で求まるハッシュ値をデータの記憶場所とする。しかし、異なるデータでも同じハッシュ値が求まった場合、どうすれば良いか?

ハッシュ法を簡単なイメージで説明すると、100個の椅子(ハッシュ表)が用意されていて、1クラスの学生が自分の電話番号の末尾2桁(ハッシュ関数)の場所(ハッシュ値)に座るようなもの。自分のイスに座ろうとしたら、同じハッシュ値の人が先に座っていたら、どこに座るべきだろうか?

オープンアドレス法

先の椅子取りゲームの例え話であれば、先に座っている人がいた場合、最も簡単な椅子に座る方法は、隣が空いているか確認して空いていたらそこに座ればいい。

これをプログラムにしてみると、以下のようになる。このハッシュ法は、求まったアドレスの場所にこだわらない方式でオープンアドレス法と呼ばれる。

// オープンアドレス法

// table[] は大域変数で0で初期化されているものとする。

// 配列に電話番号と名前を保存

void entry( int phone , name ) {

int idx = hash_func( phone ) ;

while( table[ idx ].phone != 0 )

idx = (idx + 1) % HASH_SIZE ; // ひとつ後ろの席

} // idx++ でないのは何故?

table[ idx ].phone = phone ;

strcpy( table[ idx ].name , name ) ;

}

// 電話番号から名前を調べる

char* search( int phone ) {

int idx = hash_func( phone ) ;

while( table[ idx ].phone != 0 ) {

if ( table[ idx ].phone == phone )

return table[ idx ].name ;

idx = (idx + 1) % HASH_SIZE ; // ひとつ後ろの席

} // idx++ でないのは何故?

return NULL ; // 見つからなかった

}

注意:このプログラムは、ハッシュ表すべてにデータが埋まった場合、無限ループとなるので、実際にはもう少し改良が必要である。

この実装方法であれば、ハッシュ表にデータが少ない場合は、ハッシュ値を計算すれば終わり。よって、処理時間のオーダはO(1)となる。しかし、ハッシュ表がほぼ埋まっている状態だと、残りわずかな空き場所を探すようなもの。

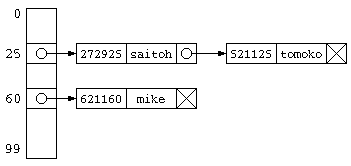

チェイン法

前に述べたオープンアドレス法は、ハッシュ衝突が発生した場合、別のハッシュ値を求めそこに格納する。配列で実装した場合であれば、ハッシュ表のサイズ以上の データ件数を保存することはできない。

チェイン法は、同じハッシュ値のデータをグループ化して保存する方法。 同じハッシュ値のデータは、リスト構造とするのが一般的。ハッシュ値を求めたら、そのリスト構造の中からひとつづつ目的のデータを探す処理となる。

この処理にかかる時間は、データ件数が少なければ、O(1) となる。しかし、ハッシュ表のサイズよりかなり多いデータ件数が保存されているのであれば、ハッシュ表の先に平均「N/ハッシュ表サイズ」件のデータがリスト構造で並んでいることになるので、O(N) となってしまう。

#define SIZE 100

int hash_func( int ph ) {

return ph % SIZE ;

}

struct PhoneNameList {

int phone ;

char name[ 20 ] ;

struct PhoneNameList* next ;

} ;

struct PhoneNameList* hash[ SIZE ] ; // NULLで初期化

struct PhoneNameList* cons( int ph ,

char* nm ,

struct PhoneNameList* nx ) {

struct PhoneNameList* ans ;

ans = (struct PhoneNameList*)malloc(

sizeof( struct PhoneNameList ) ) ;

if ( ans != NULL ) {

ans->phone = ph ;

strcpy( ans->name , nm ) ;

ans->next = nx ;

}

return ans ;

}

void entry( int phone , char* name ) {

int idx = hash_func( phone ) ;

hash[ idx ] = cons( phone , name , hash[ idx ] ) ;

}

char* search( int phone ) {

int idx = hash_func( phone ) ;

struct PhoneNameList* p ;

for( p = hash[ idx ] ; p != NULL ; p = p->next ) {

if ( p->phone == phone )

return p->name ;

}

return NULL ;

}

文字列のハッシュ値

ここまでで説明した事例は、電話番号をキーとするものであり、余りを求めるだけといったような簡単な計算で、ハッシュ値が求められた。しかし、一般的には文字列といったような名前から、ハッシュ値が欲しいことが普通だろう。

ハッシュ値は、簡単な計算で、見た目デタラメな値が求まればいい。 (ただしく言えば、ハッシュ値の出現確率が極力一様であること)。一見規則性が解らない値として、文字であれば文字コードが考えられる。複数の文字で、これらの文字コードを加えるなどの計算をすれば、 偏りの少ない値を取り出すことができる。

int hash_func( char s[] ) {

int sum = 0 ;

for( int i = 0 ; s[i] != '¥0' ; i++ ) {

sum = sum + s[i] ;

}

return sum % SIZE ;

}

文字列順で異なる値となるように

前述のハッシュ関数は、”ABC”さんと”CBA”さんでは、同じハッシュ値が求まってしまう。文字列順で異なる値が求まるように改良してみる。

int hash_func( char s[] ) {

int sum = 0 ;

for( int i = 0 ; s[i] != '¥0' ; i++ ) {

sum = sum*2 + s[i] ;

// sum = (sum * 小さい素数 + s[i]) % 大きい素数 ;

}

return sum % SIZE ;

}

上記のプログラムの、sum = sum*2 + s[i] では、2倍していった数を最後に SIZE で割っているだけなので、文字が長い場合文字コードの値の違いが sum の中に残らない場合も考えられる。こういった場合には、以下のような方法も考えられる。大きな素数で割ることで、余りの中に、元の数の値の違いの影響が残る。これは、疑似乱数生成での剰余法(or 線形合同法)の考え方を取り入れた方法ともいえる。

#define PRIME_B 大きな素数

#define PRIME_A 小さな素数

int hash_func( char s[] ) {

int sum = 0 ;

for( int i = 0 ; s[i] != '¥0' ; i++ ) {

sum = (sum * PRIME_A + s[i]) % PRIME_B ;

}

return sum % SIZE ;

}

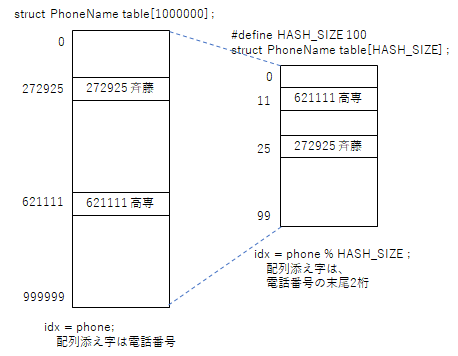

ハッシュ法(導入)

前半は中間試験の返却と解説を行う。後半は次のテーマのハッシュ法の導入話。

ここまでの授業では、配列(データ検索は、登録順保存ならO(N)、2分探索ならO(log N)となる、2分探索ができるのは配列がランダムアクセスができるからこそ)、単純リスト(データ検索(シーケンシャルアクセスしかできないのでO(N)となる)、2分探索木( O(log N) ) といった手法を説明してきた。しかし、もっと高速なデータ検索はできないのであろうか?

究極のシンプルなやり方(メモリの無駄)

最も簡単なアルゴリズムは、電話番号から名前を求めるようなデータベースであれば、電話番号自身を配列添え字番号とする方法がある。しかしながら、この方法は大量のメモリを必要とする。

// メモリ無駄遣いな超高速方法

struct PhoneName {

int phone ;

char name[ 20 ] ;

} ;

// 電話番号は6桁とする。

struct PhoneName table[ 1000000 ] ; // 携帯電話番号ならどーなる!?!?

// 配列に電話番号と名前を保存

void entry( int phone , char* name ) {

table[ phone ].phone = phone ;

strcpy( table[ phone ].name , name ) ;

}

// 電話番号から名前を調べる

char* search( int phone ) {

return table[ phone ].name ;

}

しかし、50人程度のデータであれば、電話番号の末尾2桁を取り出した場合、同じ数値の人がいることは少ないであろう。であれば、電話番号の末尾2桁の値を配列の添え字番号として、データを保存すれば、配列サイズは100件となり、メモリの無駄を減らすことができる。

ハッシュ法

先に述べたように、データの一部を取り出して、それを配列の添え字番号として保存することで、高速にデータを読み書きできるようにするアルゴリズムはハッシュ法と呼ばれる。データを格納する表をハッシュ表、データの一部を取り出した添え字番号はハッシュ値、ハッシュ値を得るための関数がハッシュ関数と呼ばれる。

// ハッシュ衝突を考えないハッシュ法

#define HASH_SIZE 100 ;

struct PhoneName table[ HASH_SIZE ] ;

// ハッシュ関数

int hash_func( int phone ) {

return phone % HASH_SIZE ;

}

// 配列に電話番号と名前を保存

void entry( int phone , name ) {

int idx = hash_func( phone ) ;

table[ idx ].phone = phone ;

strcpy( table[ idx ].name , name ) ;

}

// 電話番号から名前を調べる

char* search( int phone ) {

int idx = hash_func( phone ) ;

return table[ idx ].name ;

}

ただし、上記のプログラムでは、電話番号の末尾2桁が偶然他の人と同じになることを考慮していない。

例えば、データ件数が100件あれば、同じ値の人も出てくるであろう。このように、異なるデータなのに同じハッシュ値が求まることを、ハッシュ衝突と呼ぶ。

たとえ話で言うなら、100個の椅子が連番付きで並んでいて、自分の電話番号末尾2桁の場所に座ろうとしたら、先に座っている人がいるような状態である。このような状態で、あなたなら何処に座るだろうか?

ハッシュ関数に求められる特性

ハッシュ関数は、できる限り同じような値が求まるものは、ハッシュ衝突が多発するので、避けなければならない。例えば、6桁の電話番号の先頭2桁であれば、電話番号の局番であり、同じ学校の人でデータを覚えたら、同じ地域の人でハッシュ衝突が発生してしまう。また、ハッシュ値を計算するのに、配列の空き場所を一つ一つ探すような方式では、データ件数に比例した時間がかかり、高速なアルゴリズムでなくなってしまう。このことから、ハッシュ関数には以下のような特徴が必要となる。

- 同じハッシュ値が発生しづらい(一見してデタラメのように見える値)

- 簡単な計算で求まること。

- 同じデータに対し常に、同じハッシュ値が求まること。

理解度確認・小テスト

2分木による構文木とデータベースとB木

2項演算と構文木

演算子を含む式が与えられたとして、古いコンパイラではそれを逆ポーランド変換して計算命令を生成していた。しかし最近の複雑な言語では、計算式や命令を処理する場合、その式(または文)の構造を表す2分木(構文木)を生成する。。

+ / \ 1 * / \ 2 3

演算子の木のノードで、末端は数値であることに注目し、右枝・左枝がNULLなら数値(data部にはその数値)、それ以外は演算子(data部には演算子の文字コード)として扱うとして、上記の構文木のデータを作る処理と、その構文木の値を計算するプログラムを示す。

struct Tree {

int data ;

struct Tree* left ;

struct Tree* right ;

} ;

struct Tree* tree_int( int x ) // 数値のノード

{

struct Tree* n ;

n = (struct Tree*)malloc( sizeof( struct Tree ) ) ;

if ( n != NULL ) {

n->data = x ;

n->left = n->right = NULL ;

}

return n ;

}

struct Tree* tree_op( int op , // 演算子のノード

struct Tree* l , struct Tree* r ) {

struct Tree* n ;

n = (struct Tree*)malloc( sizeof( struct Tree ) ) ;

if ( n != NULL ) { // ~~~~~~~~~~~~~~~~~~~~~(D)

n->data = op ;

n->left = l ;

n->right = r ;

}

return n ;

}

// 与えられた演算子の木を計算する関数

int eval( struct Tree* p ) {

if ( p->left == NULL && p->right == NULL ) {

// 数値のノードは値を返す

return p->data ;

} else {

// 演算子のノードは、左辺値,右辺値を求め

// その計算結果を返す

switch( p->data ) {

case '+' : return eval( p->left ) + eval( p->right ) ;

case '*' : return eval( p->left ) * eval( p->right ) ;

} // ~~~~~~~~~~~~~~~(E) ~~~~~~~~(F)

}

}

void main() {

struct Tree* exp = // 1+(2*3) の構文木を生成

tree_op( '+' ,

tree_int( 1 ) ,

tree_op( '*' ,

tree_int( 2 ) ,

tree_int( 3 ) ) ) ;

printf( "%d¥n" , eval( exp ) ) ;

}

理解度確認

- 上記プログラム中の(A)~(F)の型を答えよ。

2分探索木の考え方を拡張したものでB木があり、データベースシステムではB木を基本としたデータ構造が活用されている。

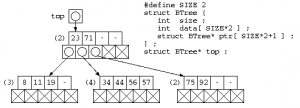

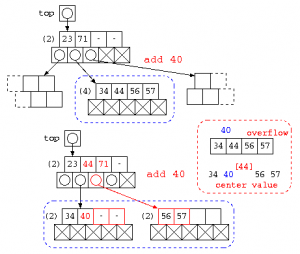

B木の構造

2分木では、データの増減で木の組換えの発生頻度が高い。そこで、1つのノード内に複数のデータを一定数覚える方法をとる。B木では、位数=Nに対し、最大2N個のデータ d0, … , d2N-1 と、2N+1本のポインタ p0, … , p2N から構成される。pi の先には、di-1< x < di を満たすデータが入った B木のノードを配置する。ただし、データの充填率を下げないようにするため、データは最小でもN個、最大で2N個を保存する。下図は位数2のB木の例を示す。

B木からデータの検索

データを探す場合は、ノード内のデータ di の中から探し、見つからない場合は、ポインタの先のデータを探す。位数がある程度大きい場合、ノード内の検索は2分探索法が使用できる。また、1つのノード内の検索が終われば、探索するデータ件数は、1/N〜1/2Nとなることから、指数的に対象件数が減っていく。よって、検索時間のオーダは、O( log N ) となる。

B木へのデータの追加

B木にデータを追加する場合は、ノード内に空きがあれば、単純にデータの追加を行う。ノード内のデータが2N個を越える場合は、以下のような処理を行う。

ノード内のデータと追加データを並べ、その中央値を選ぶ。この中央値より大きいデータは、新たにつくられたノードに移す。中央値のデータは上のノードに追加処理を行う。このような方法を取ることで、2分木のような木の偏りが作られにくい構造となるようにする。

データを削除する場合も同様に、データ件数がN個を下回る場合は、隣接するノードからデータを取ってくることで、N個を下回らないようにする。

B木とデータベース

このB木の構造は、一般的にデータベースのデータを保存するために広く利用されている。

データベースシステムでは、データを効率よく保存するだけでなく、データの一貫性が保たれるように作られている。

例えば、データベースのシステムが途中でクラッシュした場合でも、データ更新履歴の情報を元にデータを元に戻し、データを再投入して復旧できなければならない。データを複数の所からアクセスした場合に、その順序から変な値にならないように、排他制御も行ってくれる。

データベースで最も使われているシステムは、データすべてを表形式で扱うリレーショナル・データベースである。

((リレーショナル・データベースの例)) STUDENT[] RESULT[] ID | name | grade | course ID | subject | point -----+----------+-------+-------- -----+---------+------- 1001 | t-saitoh | 5 | EI 1001 | math | 83 1002 | sakamoto | 4 | E 1001 | english | 65 1003 | aoyama | 4 | EI 1002 | english | 90 外部キー ((SQLの例 2つの表の串刺し)) -- 60点以上の学生名,科目名,点数を出力 -- select STUDENT.name, RESULT.subject, RESULT.point --射影-- from STUDENT , RESULT --結合-- where STUDENT.ID == RESULT.ID -- 串刺し -- --選択-- and RESULT.point >= 60 ; ((上記SQLをC言語で書いた場合)) for( st = 0 ; st < 3 ; st++ ) // 結合(from) for( re = 0 ; re < 3 ; re++ ) if ( student[ st ].ID == result[ re ].ID // 選択(where) && result[ re ].point >= 60 ) printf( "%s %s %d" , // 射影(select) student[ st ].name , result[ re ].subject , result[ re ].point ) ;が

- 学生と成績(Paiza.ioでSQL)

- sql-mapping.cxx

B+木

データベースの処理では、目的のデータを O(log N) で見つける以外にも、全データに対する処理も重要である。この場合、全てのデータに対する処理では、単純なB木では再帰呼び出しが必要となる。しかし、他の表でも再帰処理を伴うと、プログラムは複雑になってしまう。

そこで、B木のデータを横方向に並べて処理を行う場合に、その処理が簡単になるように B+木が用いられる。

この方法では、末端のノードは、隣接するノードへのポインタを持つ。下図で示すB+木では、青で示す検索用のB木の部分と、赤で示す順次処理を行うためのシーケンスセットの部分から構成される。

演算子と言語処理系

前回追加で説明した逆ポーランド記法などの説明を再掲したうえで、構文解析といった言語処理系の話を解説する。

逆ポーランド記法

一般的に 1*2 + 3*4 と記載すると、数学的には演算子の優先順位を考慮して、(1*2)+(3*4) のように乗算を先に行う。このような優先順位を表現する時に、()を使わない方法として、逆ポーランド記法がある。

演算子の書き方には、前置記法、中置記法、後置記法があり、後置記法は、「2と3を掛ける、それに1を加える」と捉えると、日本語の処理と似ている。

中置記法 1+2*3 前置記法 +,1,*,2,3 後置記法 1,2,3,*,+ # 1と「2と3をかけた値」をたす。

後置記法は、一般的に逆ポーランド記法(Reverse Polish Notation)とも呼ばれ、式を機械語の命令に置き換える際に役立つ。

演算子の右結合・左結合

例えば、”1/2*3″という式が与えられたとする。この結果は、1/6だろうか?3/2だろうか?

一般的な数学では、優先順位が同じ演算子が並んだ場合、左側から計算を行う。つまり”1/2*3″は、”(1/2)*3″を意味する。こういった左側の優先順位が高い演算子は左結合の演算子という。

ただしC言語では、”a = b = c = 0″ と書くと、”a = (b = (c = 0))” として扱われる。こういった代入演算子は、 右結合の演算子である。

理解度確認

以下の式を指定された書き方で表現せよ。

逆ポーランド記法 1,2,*,3,4,*,+ を中置記法で表現せよ。 中置記法 (1+2)*3-4*5 を逆ポーランド記法で表現せよ。

以前の情報処理技術者試験では、スタックの概念の理解の例題として、逆ポーランド記法への変換アルゴリズムのプログラム作成が出題されることが多かったが、最近は出題されることはなくなってきた。

逆ポーランド記法の式の実行

この逆ポーランド記法で書かれた式から結果を求めるプログラムは以下のように記述できる。このプログラムでは式を簡単にするため、数値は1桁の数字のみとする。

// 単純な配列を用いたスタック

int stack[ 10 ] ;

int sp = 0 ;

void push( int x ) {

stack[ sp++ ] = x ;

}

int pop() {

return stack[ --sp ] ;

}

// 逆ポーランド記法の計算

int rpn( char* p ) {

for( ; *p != '// 単純な配列を用いたスタック

int stack[ 10 ] ;

int sp = 0 ;

void push( int x ) {

stack[ sp++ ] = x ;

}

int pop() {

return stack[ --sp ] ;

}

// 逆ポーランド記法の計算

int rpn( char* p ) {

for( ; *p != '\0' ; p++ ) {

if ( isdigit( *p ) ) {

// ~~(A)

// 数字はスタックに積む

push( *p - '0' ) ;

// ~~~~~~~~(B)

} else if ( *p == '+' ) {

// 演算子+は上部2つを取出し

int r = pop() ;

int l = pop() ;

// 加算結果をスタックに積む

push( l + r ) ;

} else if ( *p == '*' ) {

// 演算子*は上部2つを取出し

int r = pop() ;

int l = pop() ;

// 乗算結果をスタックに積む

push( l * r ) ;

}//~~~~~~~~~~~~~(C)

}

// 最終結果がスタックに残る

return pop() ;

}

void main() {

printf( "%d\n" , rpn( "123*+" ) ) ;

}

' ; p++ ) {

if ( isdigit( *p ) ) {

// ~~(A)

// 数字はスタックに積む

push( *p - '0' ) ;

// ~~~~~~~~(B)

} else if ( *p == '+' ) {

// 演算子+は上部2つを取出し

int r = pop() ;

int l = pop() ;

// 加算結果をスタックに積む

push( l + r ) ;

} else if ( *p == '*' ) {

// 演算子*は上部2つを取出し

int r = pop() ;

int l = pop() ;

// 乗算結果をスタックに積む

push( l * r ) ;

}//~~~~~~~~~~~~~(C)

}

// 最終結果がスタックに残る

return pop() ;

}

void main() {

printf( "%d\n" , rpn( "123*+" ) ) ;

}

逆ポーランド記法の式の実行は、上記のようにスタックを用いると簡単にできる。このようなスタックと簡単な命令で複雑な処理を行う方法はスタックマシンと呼ばれる。Java のバイトコードインタプリタもこのようなスタックマシンである。

Cプログラママニア向けの考察

上記のプログラムでは、int r=pop();…push(l+r); で記載しているが、

push( pop() + pop() ) ;とは移植性を考慮して書かなかった。理由を述べよ。

最初の関数電卓

初期の関数電卓では複雑な数式を計算する際に、演算子の優先順位を扱うのが困難であった。このため、HP社の関数電卓では、式の入力が RPN を用いていた。(HP-10Cシリーズ)

コンパイラと言語処理系

2分木の応用の構文木について、この後説明を行うが、構文木を使うコンパイラなどの一般知識を事前に説明しておく。

高級言語で書かれたプログラムを計算機で実行するソフトウェアは、言語処理系と呼ばれる。その実行形式により

- インタプリタ(interpreter:通訳)

- ソースプログラムの意味を解析しながら、その意味に沿った処理を行う

- コンパイラ(compiler:翻訳)

- ソースプログラムから機械語を生成し、実行する際には機械語を実行

- トランスコンパイラ

- ソースから他の言語のソースコードを生成し、それをさらにコンパイルし実行

最初のC++の実装(Cfront)では、C++をトランスレータにかけてC言語を生成し、C言語のコンパイラで動かしていた。

- ソースから他の言語のソースコードを生成し、それをさらにコンパイルし実行

- バイトコードインタプリタ

- ソースからバイトコード(機械語に近いコードを生成)、実行時にはバイトコードの命令に沿った処理を行う

- エミュレーター

- 異なるCPUのコンピュータで、システムの動作や機能を模倣して動かすシステム。

近々の例であれば、AppleのARMベースM1チップで intel CPU の動きを真似て動作させる Rosetta2 がトピック。パソコンで古いファミコンのソフトを動かすといった技術もエミュレータ。- 同じCPUで異なるOSを動かす場合は、CPU仮想化。

- 異なるCPUのコンピュータで、システムの動作や機能を模倣して動かすシステム。

に分けられる。

C言語で機械語が生成されるまで

C言語のプログラムから、機械語の命令が生成されるまでは、以下のような処理が行われる。

一般的にコンパイラの処理というと、ソースコードから機械語を生成するまでの処理を指すが、C言語ではプリプロセッサ処理を含んだり、コンパイラの処理(ソースコードからオブジェクトファイル生成まで)のほかにリンク処理を含んで使われることも多い。

foo.c C言語のソース ↓ プリプロセッサ処理 cpp foo.c(#行の無いC言語のソース) ↓ コンパイラ gcc foo.obj(オブジェクトファイル/中間コード) unix系では foo.o ↓ (+) ← ライブラリ(scanf,printfなどの組み込み関数などをまとめたもの) ↓ リンカ(リンケージエディタ) ld foo.exe

コンパイラの処理

コンパイラが命令を処理する際には、以下の処理が行われる。

- 字句解析(lexical analysys)

文字列を言語要素(token)に分解 - 構文解析(syntax analysys)

tokenの並び順に意味を反映した構造を生成 - 意味解析(semantics analysys)

命令に合わせた中間コードを生成 - 最適化(code optimization)

中間コードを変形して効率よいプログラムに変換 - コード生成(code generation)

実際の命令コード(オブジェクトファイル)として出力

バイトコードインタプリタとは

例年だと説明していなかったけど最近利用されるプログラム言語の特徴を説明。

通常、コンパイラとかインタプリタの説明をすると、Java がコンパイラとか、JavaScript はインタプリタといった説明となる。しかし、最近のこういった言語がどのように処理されるのかは、微妙である。

(( Java の場合 )) foo.java (ソースコード) ↓ Java コンパイラ foo.class (中間コード) ↓ JRE(Java Runtime Engine)の上で 中間コードをインタプリタ方式で実行

あらかじめコンパイルされた中間コードを、JREの上でインタプリタ的に実行するものは、バイトコードインタプリタ方式と呼ぶ。

ただし、JRE でのインタプリタ実行では遅いため、最近では JIT コンパイラ(Just-In-Time Compiler)により、中間コードを機械語に変換してから実行する。

また、JavaScriptなどは(というか最近のインタプリタの殆どPython,PHP,Perl,…は)、一般的にはインタプリタに分類されるが、実行開始時に高級言語でかかれたコードから中間コードを生成し、そのバイトコードをインタプリタ的に動かしている。

しかし、インタプリタは、ソースコードがユーザの所に配布されて実行するので、プログラムの内容が見られてしまう。プログラムの考え方が盗まれてしまう。このため、変数名を短くしたり、空白を除去したり(…部分的に暗号化したり)といった難読化を行うのが一般的である。

トークンと正規表現(字句解析)

字句解析でトークンを表現するために、規定されたパターンの文字列を表現する方法として、正規表現(regular expression)が用いられる。

((正規表現の書き方)) 選言 「abd|acd」は、abd または acd にマッチする。 グループ化 「a(b|c)d」は、真ん中の c|b をグループ化 量化 パターンの後ろに、繰り返し何回を指定 ? 直前パターンが0個か1個 「colou?r」 * 直前パターンが0個以上繰り返す 「go*gle」は、ggle,gogle,google + 直前パターンが1個以上繰り返す 「go+gle」は、gogle,google,gooogle

正規表現は、sed,awk,Perl,PHPといった文字列処理の得意なプログラム言語でも利用できる。こういった言語では、以下のようなパターンを記述できる。

[文字1-文字2...] 文字コード1以上、文字コード2以下 「[0-9]+」012,31415,...数字の列 ^ 行頭にマッチ $ 行末にマッチ ((例)) [a-zA-Z_][a-zA-Z_0-9]* C言語の変数名にマッチする正規表現

構文とバッカス記法

言語の文法(構文)を表現する時、バッカス記法(BNF)が良く使われる。

((バッカス記法)) <表現> ::= <表現1...> | <表現2...> | <表現3...> | ... ;

例えば、加減乗除記号と数字だけの式の場合、以下の様なBNFとなる。

((加減乗除式のバッカス記法))

<加算式> ::= <乗算式> '+' <乗算式> 【要注意】わざと間違っている部分あり

| <乗算式> '-' <乗算式>

| <乗算式>

;

<乗算式> ::= <数字> '*' <乗算式>

| <数字> '/' <乗算式>

| <数字>

;

<数字> ::= [0-9]+

;

上記のバッカス記法には、間違いがある。”1+2+3″を正しく認識できない。どこが間違っているだろうか?

このような構文が与えられた時、”1+23*456″と入力されたものを、“1,+,23,*,456”と区切る処理が、字句解析である。

また、バッカス記法での文法に合わせ、以下のような構文木を生成するのが構文解析である。

+ / \ 1 * / \ 23 456

理解度確認

- インタプリタ方式で、処理速度が遅い以外の欠点をあげよ。

- 情報処理技術者試験の正規表現,BNF記法問題にて理解度を確認せよ。

- ソースプログラムがコンパイラにより機械語が生成されるまでの処理について説明せよ。