フィルタプログラム

パイプを使うと、標準入力からデータをもらい・標準出力に結果を出力するような簡単なプログラムを組み合わせて、様々な処理が簡単にできる。こういったプログラムは、フィルタと呼ぶ。

簡単な例として、入力をすべて大文字に変換するプログラム(toupper)、入力文字をすべて小文字に変換するプログラム(tolower)が、下記の例のように保存してあるので動作を確かめよ。

guest00@nitfcei:~$ cp /home0/Challenge/2.1-RedirectPipe.d/toupper.c .

guest00@nitfcei:~$ gcc -o toupper toupper.c .

guest00@nitfcei:~$ cat toupper.c | ./toupper

#INCLUDE <STDIO.H>

#INCLUDE <CTYPE.H>

INT MAIN() {

INT C ;

WHILE( (C = GETCHAR()) != EOF )

PUTCHAR( TOUPPER( C ) ) ;

RETURN 0 ;

}

guest00@nitfcei:~$ cp /home0/Challenge/2.1-RedirectPipe.d/tolower.c .

guest00@nitfcei:~$ gcc -o tolower tolower.c

guest00@nitfcei:~$ cat tolower.c | ./tolower

(((何が出力されるか答えよ)))

よく使われるフィルタのまとめ

| 文字パターンを含む行だけ出力 | grep 文字パターン |

| 文字パターンを含まない行を出力 文字パターンを正規表現でマッチングし該当行を出力 大文字小文字を区別しない |

grep -v 文字パターン grep -e 正規表現 grep -i 文字パターン |

| 入力文字数・単語数・行数をカウント(word counter) | wc |

| 入力行数をカウント | wc -l |

| データを昇順に並べる | sort |

| データを降順に並べる 先頭を数字と見なしてソート(-gなしの場合、文字とみなしてソート) |

sort -r sort -g |

| 同じ行データが連続したら1つにまとめる | uniq |

| 同じ行が連続したら1つにまとめ、連続した数を出力 | uniq -c |

| 空白区切りで指定した場所(1番目)を抽出 | awk ‘{print$1;}’ |

| 入力の先頭複数行を表示(10行) | head |

| 入力の末尾複数行を表示(10行) | tail |

| 指定した行数だけ、先頭/末尾を表示 | head -行数 tail -行数 |

| 入力したデータを1画面分表示した所で一時停止する(ページャ) more は、最も単純なページャで、SPACE で1画面送り、ENTER で1行送り、”q”で終了。 lv は前後に移動できるページャで、カーソルキー↑(b)↓(f) で行を前後に移動できる。 |

more lv |

LOG解析

Linux は利用者に様々なサービスを提供するサーバで広く利用されている。しかし、幅広いサービス提供となると、中にはウィルス拡散や個人情報収集のための悪意のあるアクセスも増えてくる。

このためサーバでは、アクセスを受けた時の状況を記録し保存する。このような情報はアクセス履歴、ログと呼ぶ。

ログの中には、以下のような情報が混在することになるが、大量の 1. や 2. 目的のアクセスの中に、3. や 4. といったアクセスが混ざることになるが、これを見逃すとシステムに不正侵入を受ける可能性もある。

- 本来の利用者からのアクセス

- 検索システムの情報収集(クローラーからのアクセス)

- 不正な情報収集のためのアクセス

- システムの不備を探して不正侵入などを試みるアクセス

今回の演習では、電子情報の web サーバのとある1日のアクセス履歴ファイルを用い、パイプ機能を使い様々なフィルタを使い LOG解析の練習を行う。

アクセス履歴の解析

Webサーバのアクセス履歴が、/home0/Challenge/2.2-LOG.d/access.log に置いてある。このファイルで簡単な確認をしてみよう。

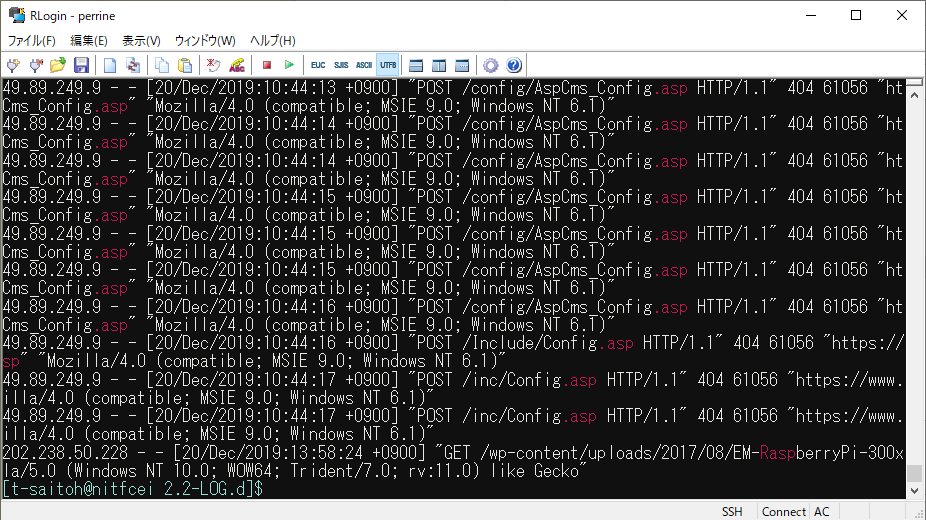

(( ファイルの場所に移動 )) $ cd /home0/Challenge/2.2-LOG.d/ (( .asp という文字を含む行を表示 )) $ grep .asp access.log

電子情報のWebサーバには、.asp (WindowsのWebサーバで動かすプログラムの拡張子) など存在しない。明らかに設定不備を探すための攻撃である。

これを見ると、grep で .asp を含む行が抜粋され、.asp の部分が強調されていることで、攻撃を簡単に確認できる。しかしこれは画面行数で10件程度が確認できるが、本当は何回攻撃を受けたのだろうか?この場合は、行数をカウントする”wc -l” を使えばいい。

(( アクセス回数を数える )) $ grep .asp access.log | wc -l 37

access.log の各項目の意味

電子情報のWebサーバの access.log に記録されている各項目の意味は以下の通り。

| 項目 | log項目 | 内容 |

|---|---|---|

| 1 | %h | リモートホスト。WebサーバにアクセスしてきたクライアントのIPアドレス |

| 2 | %l | リモートログ名。説明略。通常は “-“ |

| 3 | %u | ログインして操作するページでのユーザ名。通常は “-“ |

| 4 | %t | アクセスを受けた時刻 |

| 5 | %r | 読み込むページ。アクセス方法(GET/POSTなど)と、アクセスした場所。 |

| 6 | %>s | ステータスコード。(200成功,403閲覧禁止,404Not Found) |

| 7 | %b | 通信したデータのバイト数。 |

| 8 | %{Referer}i | Referer どのページからアクセスが発生したのか |

| 9 | %{User-Agent}i | User-Agent ブラウザ種別(どういったブラウザからアクセスされたのか) |

以下に、フィルタプログラムを活用して、色々な情報を探す例を示す。実際にコマンドを打って何が表示されるか確認しながら、フィルタプログラムの意味を調べながら、何をしているか考えよう。

.asp を使った攻撃を探す

(( .asp を試す最初の履歴を探す )) $ grep "\.asp" access.log | head -1 49.89.249.9 - - [20/Dec/2019:09:19:06 +0900] "POST /Include/md5.asp HTTP/1.1" 404 64344 "https://www.ei.fukui-nct.ac.jp/Include/md5.asp" "Mozilla/4.0 (compatible; MSIE 9.0; Windows NT 6.1)" (( 49.89.249.9 がどんなアクセスを試みているのか探す )) $ grep ^49.89.249.9 access.log | head 49.89.249.9 - - [20/Dec/2019:09:19:06 +0900] "POST /Include/md5.asp HTTP/1.1" 404 64344 "https://www.ei.fukui-nct.ac.jp/Include/md5.asp" "Mozilla/4.0 (compatible; MSIE 9.0; Windows NT 6.1)" 49.89.249.9 - - [20/Dec/2019:09:19:06 +0900] "POST /inc/md5.asp HTTP/1.1" 404 61056 "https://www.ei.fukui-nct.ac.jp/inc/md5.asp" "Mozilla/4.0 (compatible; MSIE 9.0; Windows NT 6.1)"せ

- 正規表現とは

- \.asp と先頭に \ がついているのは、ピリオドだけだと「ワイルドカード文字の任意の1文字の意味」になるため、ワイルドカードをエスケープしている。

- ^49.89…. の先頭に ^ がついているのは、行頭にマッチングさせるため。

- ステータスコードが404は”Not Found”なので、読み出しに失敗している。

- IPアドレス検索で、49.89.249.9 がどこのコンピュータか調べよう。

攻撃の時間を確認

(( 49.89.249.9 がどんな時間にアクセスを試みているのか探す ))

$ grep ^49.89.249.9 access.log | awk '{print $4;}'

[20/Dec/2019:09:19:06

[20/Dec/2019:09:19:06

[20/Dec/2019:09:19:07

:

- 不正アクセスを試みている時間を調べると、そのアクセス元の09:00~17:00に攻撃していることがわかる場合がある。どういうこと?

ページの閲覧頻度を確認

(( /~t-saitoh/ 見たIPアドレスと頻度 ))

$ grep "/~t-saitoh/" access.log | awk '{print $1;}' | sort | uniq -c | sort -g -r | head

38 151.80.39.78

35 151.80.39.209

32 203.104.143.206

31 5.196.87.138

:

- grep – “/~t-saitoh/”のページをアクセスしているデータを抽出

- awk – 項目の先頭(IPアドレス)だけ抽出

- sort – IPアドレス順に並べる(同じIPアドレスならその数だけ重複した行になる)

- uniq – 重複している行数を数える

- sort -g -r – 先頭の重複数で大きい順にソート

- head – 先頭10行だけ抽出

(( /~t-saitoh/ 見たIPアドレスと頻度 )) (( t-saitoh のテスト問題のページを誰が見ているのか? )) $ grep "/~t-saitoh/exam/" access.log 5.196.87.156 - - [20/Dec/2019:06:36:02 +0900] "GET /~t-saitoh/exam/db2009/ex2009-5-1.pdf HTTP/1.1" 200 20152 "-" "Mozilla/5.0 (compatible; AhrefsBot/6.1; +http://ahrefs.com/robot/)" : (( クローラーのアクセスが多くてよくわからないので bot を含まない行を抽出 )) $ grep "/~t-saitoh/exam/" access.log | grep -v -i bot | lv 213.242.6.61 - - [20/Dec/2019:06:33:12 +0900] "GET /%7Et-saitoh/exam/ HTTP/1.0" 200 19117 "http://www.ei.fukui-nct.ac.jp/%7Et-saitoh/exam/" "Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/67.0.3396.87 Safari/537.36 OPR/54.0.2952.64 (Edition Yx)" 188.163.109.153 - - [20/Dec/2019:06:43:04 +0900] "GET /%7Et-saitoh/exam/ HTTP/1.0" 200 19117 "http://www.ei.fukui-nct.ac.jp/%7Et-saitoh/exam/" "Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/66.0.3359.170 Safari/537.36 OPR/53.0.2907.99" 188.163.109.153 - - [20/Dec/2019:06:43:05 +0900] "POST /cgi-bin/movabletype/mt-comments.cgi HTTP/1.0" 404 432 "http://www.ei.fukui-nct.ac.jp/%7Et-saitoh/exam/" "Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/66.0.3359.170 Safari/537.36 OPR/53.0.2907.99" 45.32.193.50 - - [20/Dec/2019:07:06:15 +0900] "GET /~t-saitoh/exam/apply-prog.html HTTP/1.0" 200 5317 "http://www.ei.fukui-nct.ac.jp/" "Mozilla/5.0 (Windows NT 5.2) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/63.0.3239.132 Safari/537.36"

- この結果を見ると mt-comments.cgi というアクセスが見つかる。どうも コメントスパム(ブログのコメント欄に広告を勝手に書き込む迷惑行為)をしようとしている。

ネットワーク攻撃への対処

今回の access.log のアクセス履歴解析は、Webサーバへのアクセスへの基本的な対処となる。しかし、もっと違うネットワーク接続ではどのような対処を行うべきであろうか?

一般的には、

- サーバにネットワークアクセスの記録ソフトを使う(例ネットワークプロトコルアナライザーWireShark)

- ファイアウォールのアクセス履歴を解析

授業内レポート

- ここまでのLOG解析の例の1つについて、どういう考え方でフィルタを使っているのか、自分の言葉で説明せよ。

- LOG 解析のためのコマンドを考え、その実行結果を示し、それから何が判るか説明せよ。

(例) 自分で考えたコマンドの実行結果をつけたうえで、「コメントスパムを何度も試す危ないアクセス元は〇〇である。」 - レポート提出先フォルダ ファイル名は、出席番号2桁-名前-レポート名.docx (ファイル形式は pdf などでも良い) とする。