プロセス管理とシェルスクリプト

ジョブ管理

プログラムを実行している時、それがすごくメモリも使い計算時間もかかる処理の場合、条件を変化させながら結果が欲しい時、どのように実行すべきだろうか?1つの処理が1時間かかるとして、画面を見ながら1時間後に処理が終わったことを確認してプログラムを実行するのか?

簡単な方法としては、1つ目の処理(仮にプログラムAとする)を実行させたままで、新しくウィンドウを開いてそこで新しい条件でプログラムを並行処理すればいい(プログラムBとする)と考えるかもしれない。しかし、メモリを大量に使用する処理をいくつも並行処理させると、仮想メモリが使われるようになる。結果的にスワッピングが発生する分、プログラムAを実行させた後にプログラムBを実行するための時間以上に、時間がかかることになる。

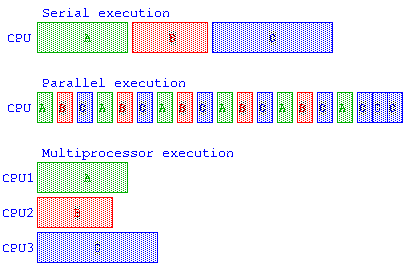

例えば、A,B,C のプロセスがあった場合、直列実行、並列実行、マルチプロセッサで並列実行のイメージ。時分割多重処理(Time Division Multiplexing – TDM) による並列実行では、各プロセスに割り当てられるCPUの最小実行単位時間をタイムクアンタム(Time Quantum)と呼ぶ。しかし、この処理のタスク切り替え(Task Switch)にかかる時間も考慮する必要がある。

ここで、プログラムを並行処理させるか、逐次処理させるといった、JOB(ジョブ)管理について説明を行う。

以下の説明で、複雑で時間のかかる処理を実行するとサーバの負担が高くなるので指定時間の処理待ちを行うための sleep 命令を使う。

逐次実行と並行実行

プログラムを連続して実行(処理Aの後に処理Bを実行する)場合には、セミコロン”;” で区切って A ; B のように処理を起動する。

guest00@nitfcei:~$ echo A A guest00@nitfcei:~$ echo A ; echo B A B

プログラムを並行して実行(処理Aと処理Bを並行処理)する場合には、アンド”&”で区切って A & B のように処理を起動する。

guest00@nitfcei:~$ sleep 5 & [1] 55 guest00@nitfcei:~$ echo A A [1]+ 終了 sleep 5 guest00@nitfcei:~$ sleep 2 & sleep 3 [1] 56 [1]+ 終了 sleep 2 guest00@nitfcei:~$ time ( sleep 1 ; sleep 1 ) # time コマンドは、コマンドの実行時間を測ってくれる。 real 0m2.007s user 0m0.005s sys 0m0.002s guest00@nitfcei:~$ time ( sleep 1 & sleep 1 ) real 0m1.002s user 0m0.003s sys 0m0.000s

fg, bg, jobs コマンド

プログラムを実行中に、処理(ジョブ)を一時停止したり、一時停止している処理を復帰させたりするときには、fg, bg, jobs コマンドを使う。

- 処理をしている時に、Ctrl-C を入力すると前面処理のプログラムは強制停止となる。

- 処理をしている時に、Ctrl-Z を入力すると前面処理のプログラムは一時停止状態になる。

- fg (フォアグラウンド) は、指定した処理を前面処理(キー入力を受け付ける処理)に変更する。

- bg (バックグラウンド) は、指定した処理を後面処理(キー入力が必要になったら待たされる処理)に変更する。

- jobs (ジョブ一覧) は、実行中や一時停止している処理(ジョブ)の一覧を表示する。

guest00@nitfcei:~$ sleep 10 # 途中で Ctrl-Z を入力する ^Z [1]+ 停止 sleep 10 guest00@nitfcei:~$ fg sleep 10 # 一時停止していた sleep 10 を実行再開 guest00@nitfcei:~$ sleep 3 ^Z [1]+ 停止 sleep 3 guest00@nitfcei:~$ sleep 4 ^Z [2]+ 停止 sleep 4 guest00@nitfcei:~$ jobs [1]- 停止 sleep 3 # [1],[2]というのはjob番号 [2]+ 停止 sleep 4 guest00@nitfcei:~$ fg %1 # ジョブ番号1 を前面処理にする sleep 3 guest00@nitfcei:~$ fg %2 # ジョブ番号2 を前面処理にする sleep 4

ps, kill コマンド

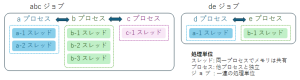

OS では、プログラムの処理単位は プロセス(process) と呼ぶ。OS はプロセスごとにメモリの実行範囲などの管理を行う。一連のプロセスを組み合わせて実行する単位を ジョブ(job) と呼ぶ。

複数のプロセスは間違ったメモリアクセスで他のプロセスが誤動作するようでは、安心して処理が実行できない。そこで、OS は、プロセスが他のプロセスのメモリをアクセスすると強制停止させるなどの保護をしてくれる。しかし、プロセスと他のプロセスが協調して処理を行うための情報交換のためにメモリを使うことは困難である。プロセス間で情報交換が必要であれば、パイプ機能やプロセス間共有メモリ機能を使う必要がある。

最近のOSでは、共通のメモリ空間で動き 並行動作する個々の処理は スレッド(thread) と呼び、その複数のスレッドをまとめたものがプロセスとなる。OS では、プロセスごとに番号が割り振られ、その番号を プロセスID(PID) と呼ぶ。実行中のプロセスを表示するには、ps コマンドを使う。

実行中のプロセスを停止する場合には、kill コマンドを用いる。停止するプログラムは、ジョブ番号(%1など) か プロセスID を指定する。

guest00@nitfcei:~$ sleep 3 ^Z [1]+ 停止 sleep 3 guest00@nitfcei:~$ sleep 4 ^Z [2]+ 停止 sleep 4 guest00@nitfcei:~$ jobs [1]- 停止 sleep 3 # [1],[2]というのはjob番号 [2]+ 停止 sleep 4 guest00@nitfcei:~$ ps w # プロセスの一覧(wを付けるとコマンドの引数も確認できる) PID TTY STAT TIME CMD 13 pts/0 Ss 00:00:00 -bash 84 pts/0 T 00:00:00 sleep 3 85 pts/0 T 00:00:00 sleep 4 86 pts/0 R 00:00:00 ps w guest00@nitfcei:~$ kill %1 [1]- Terminated sleep 3 guest00@nitfcei:~$ kill -KILL 85 [2]+ 強制終了 sleep 4 guest00@nitfcei:~$ ps ax # 他人を含めた全プロセスの一覧表示 PID TTY STAT TIME COMMAND 1 ? Ss 0:52 /sbin/init 2 ? S 0:00 [kthreadd] 3 ? I< 0:00 [rcu_gp] :

ここまでの授業では、OSでのリダイレクト・パイプの概念とプロセスの概念について説明を行ってきた。これによりプログラムの実行結果を他のプログラムに渡すことができる。これらの機能を使うと、いくつかのプログラムを次々と実行させるなどの自動化をしたくなってくる。そこで、これ以降では、OSとプログラムの間の情報を伝え合う基本機能の説明や、プログラムの起動をスクリプトとしてプログラム化するためのシェルスクリプト(shell script)について説明する。

環境変数

OSを利用していると、その利用者に応じた設定などを行いたい場合が多い。このような情報を管理する場合には、環境変数が使われる。環境変数はプロセス毎に管理され、プロセスが新しく子供のプロセス(子プロセス)を生成すると、環境変数は子プロセスに自動的に引き渡される。代表的な環境変数を以下に示す。

- HOME – ユーザがログインした際の起点となるディレクトリであり、/home/ユーザ名 となっているのが一般的。

シェルの中では”~” で代用できる。( “cd ~” で、最初のディレクトリに戻る ) - LC_ALL, LANG – ユーザが使う言語。OSからのメッセージなどを日本語で表示したい場合には、ja_JP.UTF-8 などを指定。

- TZ – ユーザの時差の情報(Time Zone) 日本であれば、”JST-9″ を設定するのが一般的。

日本標準時 “JST” で、グリニッジ標準時(GMT)との時差を表す “-9” の組み合わせ。 - PATH – ユーザがよく使うコマンドの保存されているディレクトリの一覧。/bin:/usr/bin の様にディレクトリ名を”:”区切りで書き並べる。

- LD_LIBRARY_PATH – 共有ライブラリの保存されているディレクトリの一覧。

環境変数と同じように、シェルの中で使われるものはシェル変数と呼ぶ。この変数は、子プロセスに引き渡されない。

環境変数を表示するには、env コマンド(環境変数を表示)や、set コマンド(環境変数やシェル変数を表示)を用いる。シェルの中で特定の環境変数を参照する場合には、$変数名 とする。echo コマンドで PATH を表示するなら、”echo $PATH” とすればいい。

guest00@nitfcei:~$ env SHELL=/bin/bash : guest00@nitfcei:~$ echo $PATH /bin:/usr/bin:/usr/local/bin

変数に値を設定する場合には、“変数名=値” の様に設定する。この変数を環境変数に反映させるには、export コマンドを用いるか、“export 変数名=値” を用いる。

環境変数の中で PATH は、コマンドを実行する際にコマンドの保存先を探すための変数であり、例えば PATH=/bin:/usr/bin:/usr/local/bin であったばあい、shell は、最初に /bin の中からコマンドを探し、次に /usr/bin を探し、さらに /usr/local/bin の中からコマンドを探す。PATH の設定の注意点

((( 環境変数の設定 ))) guest00@nitfcei:~$ PATH=/bin:/usr/bin guest00@nitfcei:~$ echo $PATH guest00@nitfcei:~$ export PATH guest00@nitfcei:~$ export PATH=/bin:/usr/bin:/usr/local/bin ((( PATHの確認 ))) guest00@nitfcei:~$ which zsh # which はコマンドの場所を探してくれる /bin/zsh guest00@nitfcei:~$ export PATH=/usr/local/bin:/usr/bin:/bin guest00@nitfcei:~$ which zsh /usr/bin/zsh ((( LC_ALL,LANG の確認 ))) guest00@nitfcei:~$ export LC_ALL=C guest00@nitfcei:~$ man man (英語でマニュアルが表示される) guest00@nitfcei:~$ export LC_ALL=ja_JP.UTF-8 guest00@nitfcei:~$ man man (日本語でマニュアルが表示される) ((( TZタイムゾーンの確認 ))) guest00@nitfcei:~$ export TZ=GMT-0 guest00@nitfcei:~$ date 2022年 7月 4日 月曜日 05:23:23 GMT # イギリスの時間(GMT=グリニッジ標準時間)が表示された guest00@nitfcei:~$ export TZ=JST-9 guest00@nitfcei:~$ date # 日本時間(JST=日本標準時間)で表示された 2022年 7月 4日 月曜日 14:23:32 JST guest00@nitfcei:~$ TZ=GMT-0 date ; date # 環境変数を一時的に変更して date を実行 2022年 7月 4日 月曜日 05:23:23 GMT 2022年 7月 4日 月曜日 14:23:32 JST

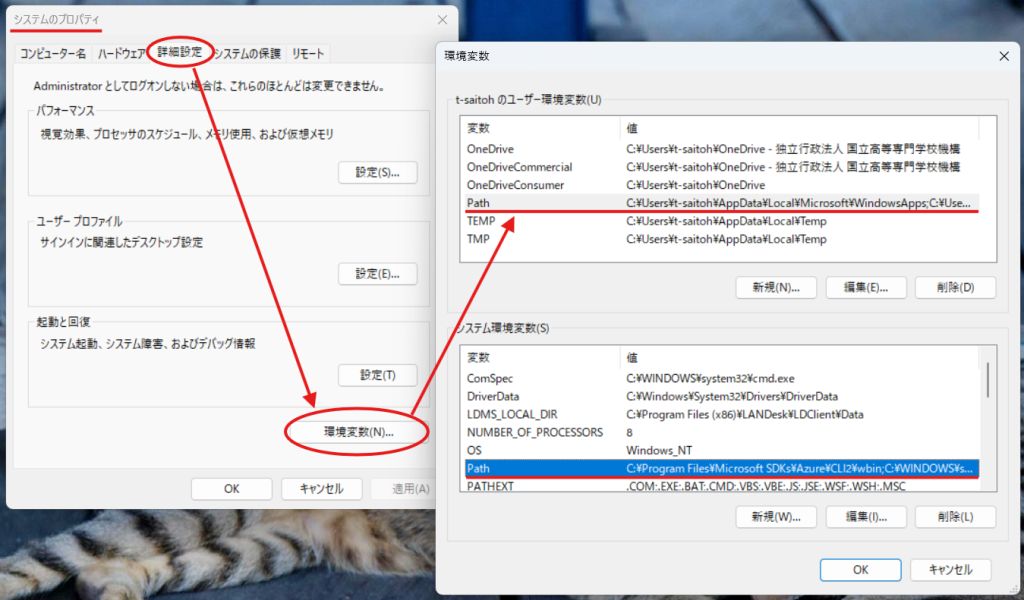

環境変数 PATH の考え方は、Windows でも同じように存在し、PATH を変更する場合には、「設定 – システムのプロパティ – 詳細設定 – 環境変数」により編集可能となる。

プログラムとコマンドライン引数と環境変数

この後に説明するシェルスクリプトなどの機能を用いる場合は、自分のプログラムとのデータのやり取りにコマンドライン引数と環境変数を使う。また、プログラムの実行に失敗した時に別の処理を実行するためには、main関数の返り値を使うことができる。

コマンドライン引数

コマンドライン引数は、プログラムを起動する時の引数として書かれている情報であり、C言語でこの情報を用いる時には、main関数の引数”int main( int argc , char** argv ) …” により値をもらうことができ、以下のようなプログラムを記述することで受け取ることができる。

# 参考として Java の場合のコマンドライン引数の取得方法も示す。

((( argv.c )))

#include <stdio.h>

int main( int argc , char** argv ) {

for( int i = 0 ; i < argc ; i++ ) {

printf( "argv[%d] = %s\n" , i , argv[ i ] ) ;

}

return 0 ;

}

((( argv.c を実行してみる )))

guest00@nitfcei:~$ cp /home0/Challenge/3-shellscript/argv.c .

guest00@nitfcei:~$ gcc argv.c

guest00@nitfcei:~$ ./a.out 111 aaa 234 bcdef

argv[0] = ./a.out

argv[1] = 111

argv[2] = aaa

argv[3] = 234

argv[4] = bcdef

((( Argv.java )))

import java.util.* ;

public class Argv {

public static void main( String[] args ) throws Exception {

for( int i = 0 ; i < args.length ; i++ )

System.out.println( "args["+i+"] = "+args[i] ) ;

}

}

((( Argv.java を実行してみる )))

guest00@nitfcei:~$ cp /home0/Challenge/3-shellscript/Argv.java .

guest00@nitfcei:~$ javac Argv.java

guest00@nitfcei:~$ java Argv 111 aaa 234 bcdef

args[0] = 111 # Java では コマンド名argv[0]は引数に含まれない

args[1] = aaa

args[2] = 234

args[3] = bcdef

注意点:コマンドライン引数の0番目には、プロセスを起動した時のプロセス名が入る。

環境変数の参照

C言語のmain関数は、コマンドライン引数のほかに環境変数も参照することができる。envpの情報は、getenv関数でも参照できる。

((( argvenvp.c )))

#include <stdio.h>

int main( int argc , char** argv , char** envp ) {

// コマンドライン引数argc,argvの処理

for( int i = 0 ; i < argc ; i++ ) {

printf( "argv[%d] = %s\n" , i , argv[ i ] ) ;

}

// 環境変数envpの処理

for( int i = 0 ; envp[i] != NULL ; i++ ) {

printf( "envp[%d] = %s\n" , i , envp[ i ] ) ;

}

return 0 ;

}

((( argvenvp.c を実行してみる )))

guest00@nitfcei:~$ cp /home0/Challenge/3-shellscript/argvenvp.c .

guest00@nitfcei:~$ gcc argvenvp.c

guest00@nitfcei:~$ ./a.out

argv[0] = ./a.out

envp[0] = SHELL=/bin/bash

:

プロセスの返す値

プログラムによっては、処理が上手くいかなかったことを検知して、別の処理を実行したいかもしれない。

こういう場合には、C言語であれば main の返り値に 0 以外の値で return させる。( exit関数を使ってもいい )

以下の例では、入力値の平均を出力するが、データ件数が0件であれば平均値を出力できない。こういう時に、”return 1 ;” のように値を返せば、シェル変数 $? (直前のコマンドの返り値) に return で返された値を参照できる。

((( average.c )))

#include <stdio.h>

int main() {

int count = 0 ;

int sum = 0 ;

char buff[ 1024 ] ;

while( fgets( buff , sizeof( buff ) , stdin ) != NULL ) {

int value ;

if ( sscanf( buff , "%d" , &value ) == 1 ) {

sum += value ;

count++ ;

}

}

if ( count == 0 ) {

// データ件数が0の場合は平均が計算できない。

fprintf( stderr , "No data\n" ) ;

// プログラムが失敗したことを返すには 0 以外の値を return する。

return 1 ; // exit( 1 ) ;

} else {

printf( "%lf\n" , (double)sum / (double)count ) ;

}

return 0 ;

}

((( average.c を動かしてみる )))

guest00@nitfcei:~$ gcc average.c

guest00@nitfcei:~$ ./a.out

12

14

^D # Ctrl-D で入力を終わらせる

13.00000

guest00@nitfcei:~$ echo $? # プロセスの実行結果の値を参照するためのシェル変数 $?

0

guest00@nitfcei:~$ ./a.out

^D # データを入力せずにすぐに終了させる。

No data

guest00@nitfcei:~$ echo $?

1

シェルスクリプト

今まで、コマンドラインで命令の入力をしてきたが、こういったキーボードと対話的処理を行うプログラムは shell (シェル) と呼ばれ、今回の演習では、/bin/bash を用いている。 shell は、キーボードとの対話的処理だけでなく、shell で入力するような処理をファイルに記録しておき、そのファイルに記載されている順に処理を実行することができる。

guest00@nitfcei:~$ cp /home0/Challenge/3-shellscript/helloworld.sh . guest00@nitfcei:~$ cat helloworld.sh #!/bin/bash echo "Hello World" message="こんにちは" # シェル変数への代入 echo "Hello World = $message" # シェル変数の参照 guest00@nitfcei:~$ bash helloworld.sh # bash で helloworld.sh を実行する Hello World Hello World = こんにちは

シェルスクリプトの基本は、キー入力で実行するようなコマンドを書き並べればいい。

しかし、プログラムを実行する度に、bash ファイル名 と入力するのは面倒。こういう時には以下の2つの設定を行う。

- シェルスクリプトの先頭行に 実行させる shell の名前の前に “#!” をつける。

この行は、通称”シバン shebang (シェバン)“と呼ばれ、bashで実行させたいのなら”#!/bin/bash“、プログラミング言語 Perl で実行させたいのなら “#!/usr/bin/perl” とか、Python で実行させたいのなら、”#!/usr/bin/python” のようにすればいい。(今回のサンプルはすでに記入済み) - 保存したスクリプトに対して、実行権限を与える。

“ls -al “で “rw-r–r–” のようなファイルの書き込みパーミッションが表示されるが、通常ファイルの場合は、“x”の表示があると、プログラムとして実行可能となる。(フォルダであれば、rwxr-xr-x のように”x”の表示があると、フォルダの中に入ることができる)

((( 実効権限の設定 ))) guest00@nitfcei:~$ chmod 755 helloworld.sh guest00@nitfcei:~$ ./helloworld.sh Hello World Hello World = こんにちは

$HOME/.bashrc

シェルスクリプトは、Linux の環境設定を行うためのプログラム言語として使われている。

例えば、ユーザがログインする際には、そのユーザがどういった言語を使うのか(LC_LANG,LANG)や、どういったプログラムをよく使うのか(PATH,LD_LIBRARY_PATH)などは、そのユーザの好みの設定を行いたい。こういう時に、shell に bash を使っているのであれば、$HOME/.bashrc に、shell を使う際の自分好みの設定を記載すればいい。

((( $HOME/.bashrc の例 )))

#!/bin/bash

# PATHの設定

export PATH=/usr/local/bin:/usr/bin:/bin

# MacOS でインストールされているソフトで PATH を切り替える

if [ -d /opt/homebrew/bin ]; then # /opt/homebrew/bin のディレクトリがあるならば...

# HomeBrew

export PATH=/opt/homebrew/bin:$PATH

elif [ -d /opt/local/bin ]; then # /opt/local/bin のディレクトリがあるならば...

# MacPorts

export PATH="/opt/local/bin:$PATH"

fi

ユーザ固有の設定以外にも、OSが起動する時に、起動しておくべきプログラムの初期化作業などにもシェルスクリプトが使われている。

例えば、/etc/init.d/ フォルダには、Webサーバ(apache2)やsshサーバ(ssh) といったサーバを起動や停止をするための処理が、シェルスクリプトで記載してあり、OS 起動時に必要に応じてこれらのシェルスクリプトを使ってサーバソフトを起動する。(ただし最近は systemd が使われるようになってきた)

理解度確認

LOG解析のおまけ

ログ解析のレポートを早々に提出してくれたものの中に、64.124.8.135 からのアクセスが沢山あった…との結果だけど、

$ grep 2025-06-24-access.log 64.124.8.135 | head -1 64.124.8.135 - - [24/Jun/2025:04:07:08 +0900] "GET /~t-saitoh/etc/2013/1301191410-1_640x480.jpg HTTP/1.1" 404 501 "-" "Mozilla/5.0 (compatible; ImagesiftBot; +imagesift.com)"

この結果を見ると、LOGの履歴の最後は、”Mozilla/5.0 (compatible; ImagesiftBot; +imagesift.com)” となっている。この欄は、ユーザエージェント欄で、相手がどんなブラウザでアクセスしているかなどが分かる欄。でも、注目すべきなのは、 ImagesiftBot という項目がある。これは、ブラウザではなくデータ検索ロボット(Bot)だと思われる。名前からして、画像に特化したロボットが、いくつかの画像ファイルをまとめて取っていったのだろう。

パイプとフィルタ

フィルタプログラム

パイプを使うと、標準入力からデータをもらい・標準出力に結果を出力するような簡単なプログラムを組み合わせて、様々な処理が簡単にできる。こういったプログラムは、フィルタと呼ぶ。

簡単な例として、入力をすべて大文字に変換するプログラム(toupper)、入力文字をすべて小文字に変換するプログラム(tolower)が、下記の例のように保存してあるので動作を確かめよ。

guest00@nitfcei:~$ cp /home0/Challenge/2.1-RedirectPipe.d/toupper.c .

guest00@nitfcei:~$ gcc -o toupper toupper.c .

guest00@nitfcei:~$ cat toupper.c | ./toupper

#INCLUDE <STDIO.H>

#INCLUDE <CTYPE.H>

INT MAIN() {

INT C ;

WHILE( (C = GETCHAR()) != EOF )

PUTCHAR( TOUPPER( C ) ) ;

RETURN 0 ;

}

guest00@nitfcei:~$ cp /home0/Challenge/2.1-RedirectPipe.d/tolower.c .

guest00@nitfcei:~$ gcc -o tolower tolower.c

guest00@nitfcei:~$ cat tolower.c | ./tolower

(((何が出力されるか答えよ)))

よく使われるフィルタのまとめ

| 文字パターンを含む行だけ出力 | grep 文字パターン |

| 文字パターンを含まない行を出力 文字パターンを正規表現でマッチングし該当行を出力 大文字小文字を区別しない |

grep -v 文字パターン grep -e 正規表現 grep -i 文字パターン |

| 入力文字数・単語数・行数をカウント(word counter) | wc |

| 入力行数をカウント | wc -l |

| データを昇順に並べる | sort |

| データを降順に並べる 先頭を数字と見なしてソート(-gなしの場合、文字とみなしてソート) |

sort -r sort -g |

| 同じ行データが連続したら1つにまとめる | uniq |

| 同じ行が連続したら1つにまとめ、連続した数を出力 | uniq -c |

| 空白区切りで指定した場所(1番目)を抽出 | awk ‘{print$1;}’ |

| 入力の先頭複数行を表示(10行) | head |

| 入力の末尾複数行を表示(10行) | tail |

| 指定した行数だけ、先頭/末尾を表示 | head -行数 tail -行数 |

| 入力したデータを1画面分表示した所で一時停止する(ページャ) more は、最も単純なページャで、SPACE で1画面送り、ENTER で1行送り、”q”で終了。 lv は前後に移動できるページャで、カーソルキー↑(b)↓(f) で行を前後に移動できる。 |

more lv |

LOG解析

Linux は利用者に様々なサービスを提供するサーバで広く利用されている。しかし、幅広いサービス提供となると、中にはウィルス拡散や個人情報収集のための悪意のあるアクセスも増えてくる。

このためサーバでは、アクセスを受けた時の状況を記録し保存する。このような情報はアクセス履歴、ログと呼ぶ。

ログの中には、以下のような情報が混在することになるが、大量の 1. や 2. 目的のアクセスの中に、3. や 4. といったアクセスが混ざることになるが、これを見逃すとシステムに不正侵入を受ける可能性もある。

- 本来の利用者からのアクセス

- 検索システムの情報収集(クローラーからのアクセス)

- 不正な情報収集のためのアクセス

- システムの不備を探して不正侵入などを試みるアクセス

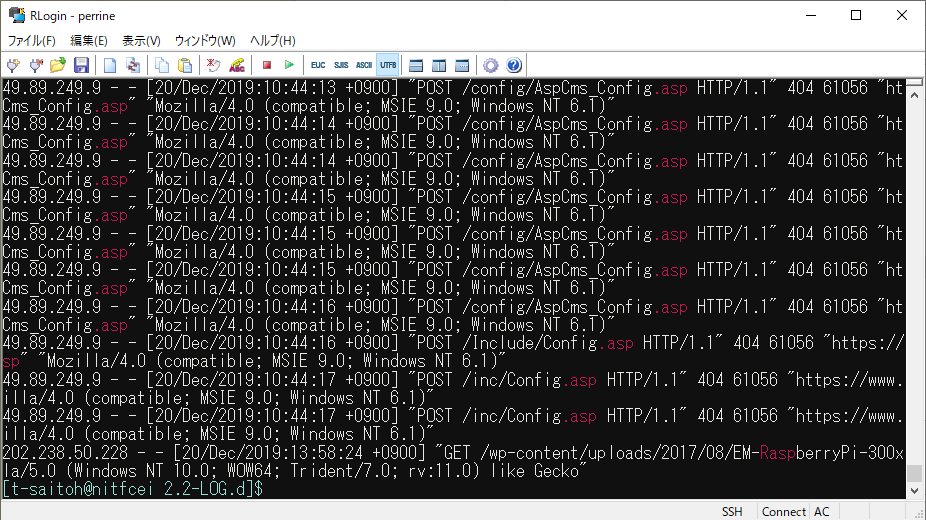

今回の演習では、電子情報の web サーバのとある1日のアクセス履歴ファイルを用い、パイプ機能を使い様々なフィルタを使い LOG解析の練習を行う。

アクセス履歴の解析

Webサーバのアクセス履歴が、/home0/Challenge/2.2-LOG.d/access.log に置いてある。このファイルで簡単な確認をしてみよう。

(( ファイルの場所に移動 )) $ cd /home0/Challenge/2.2-LOG.d/ (( .asp という文字を含む行を表示 )) $ grep .asp access.log

電子情報のWebサーバには、.asp (WindowsのWebサーバで動かすプログラムの拡張子) など存在しない。明らかに設定不備を探すための攻撃である。

これを見ると、grep で .asp を含む行が抜粋され、.asp の部分が強調されていることで、攻撃を簡単に確認できる。しかしこれは画面行数で10件程度が確認できるが、本当は何回攻撃を受けたのだろうか?この場合は、行数をカウントする”wc -l” を使えばいい。

(( アクセス回数を数える )) $ grep .asp access.log | wc -l 37

access.log の各項目の意味

電子情報のWebサーバの access.log に記録されている各項目の意味は以下の通り。

| 項目 | log項目 | 内容 |

|---|---|---|

| 1 | %h | リモートホスト。WebサーバにアクセスしてきたクライアントのIPアドレス |

| 2 | %l | リモートログ名。説明略。通常は “-“ |

| 3 | %u | ログインして操作するページでのユーザ名。通常は “-“ |

| 4 | %t | アクセスを受けた時刻 |

| 5 | %r | 読み込むページ。アクセス方法(GET/POSTなど)と、アクセスした場所。 |

| 6 | %>s | ステータスコード。(200成功,403閲覧禁止,404Not Found) |

| 7 | %b | 通信したデータのバイト数。 |

| 8 | %{Referer}i | Referer どのページからアクセスが発生したのか |

| 9 | %{User-Agent}i | User-Agent ブラウザ種別(どういったブラウザからアクセスされたのか) |

以下に、フィルタプログラムを活用して、色々な情報を探す例を示す。実際にコマンドを打って何が表示されるか確認しながら、フィルタプログラムの意味を調べながら、何をしているか考えよう。

.asp を使った攻撃を探す

(( .asp を試す最初の履歴を探す )) $ grep "\.asp" access.log | head -1 49.89.249.9 - - [20/Dec/2019:09:19:06 +0900] "POST /Include/md5.asp HTTP/1.1" 404 64344 "https://www.ei.fukui-nct.ac.jp/Include/md5.asp" "Mozilla/4.0 (compatible; MSIE 9.0; Windows NT 6.1)" (( 49.89.249.9 がどんなアクセスを試みているのか探す )) $ grep ^49.89.249.9 access.log | head 49.89.249.9 - - [20/Dec/2019:09:19:06 +0900] "POST /Include/md5.asp HTTP/1.1" 404 64344 "https://www.ei.fukui-nct.ac.jp/Include/md5.asp" "Mozilla/4.0 (compatible; MSIE 9.0; Windows NT 6.1)" 49.89.249.9 - - [20/Dec/2019:09:19:06 +0900] "POST /inc/md5.asp HTTP/1.1" 404 61056 "https://www.ei.fukui-nct.ac.jp/inc/md5.asp" "Mozilla/4.0 (compatible; MSIE 9.0; Windows NT 6.1)"せ

- 正規表現とは

- \.asp と先頭に \ がついているのは、ピリオドだけだと「ワイルドカード文字の任意の1文字の意味」になるため、ワイルドカードをエスケープしている。

- ^49.89…. の先頭に ^ がついているのは、行頭にマッチングさせるため。

- ステータスコードが404は”Not Found”なので、読み出しに失敗している。

- IPアドレス検索で、49.89.249.9 がどこのコンピュータか調べよう。

攻撃の時間を確認

(( 49.89.249.9 がどんな時間にアクセスを試みているのか探す ))

$ grep ^49.89.249.9 access.log | awk '{print $4;}'

[20/Dec/2019:09:19:06

[20/Dec/2019:09:19:06

[20/Dec/2019:09:19:07

:

- 不正アクセスを試みている時間を調べると、そのアクセス元の09:00~17:00に攻撃していることがわかる場合がある。どういうこと?

ページの閲覧頻度を確認

(( /~t-saitoh/ 見たIPアドレスと頻度 ))

$ grep "/~t-saitoh/" access.log | awk '{print $1;}' | sort | uniq -c | sort -g -r | head

38 151.80.39.78

35 151.80.39.209

32 203.104.143.206

31 5.196.87.138

:

- grep – “/~t-saitoh/”のページをアクセスしているデータを抽出

- awk – 項目の先頭(IPアドレス)だけ抽出

- sort – IPアドレス順に並べる(同じIPアドレスならその数だけ重複した行になる)

- uniq – 重複している行数を数える

- sort -g -r – 先頭の重複数で大きい順にソート

- head – 先頭10行だけ抽出

(( /~t-saitoh/ 見たIPアドレスと頻度 )) (( t-saitoh のテスト問題のページを誰が見ているのか? )) $ grep "/~t-saitoh/exam/" access.log 5.196.87.156 - - [20/Dec/2019:06:36:02 +0900] "GET /~t-saitoh/exam/db2009/ex2009-5-1.pdf HTTP/1.1" 200 20152 "-" "Mozilla/5.0 (compatible; AhrefsBot/6.1; +http://ahrefs.com/robot/)" : (( クローラーのアクセスが多くてよくわからないので bot を含まない行を抽出 )) $ grep "/~t-saitoh/exam/" access.log | grep -v -i bot | lv 213.242.6.61 - - [20/Dec/2019:06:33:12 +0900] "GET /%7Et-saitoh/exam/ HTTP/1.0" 200 19117 "http://www.ei.fukui-nct.ac.jp/%7Et-saitoh/exam/" "Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/67.0.3396.87 Safari/537.36 OPR/54.0.2952.64 (Edition Yx)" 188.163.109.153 - - [20/Dec/2019:06:43:04 +0900] "GET /%7Et-saitoh/exam/ HTTP/1.0" 200 19117 "http://www.ei.fukui-nct.ac.jp/%7Et-saitoh/exam/" "Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/66.0.3359.170 Safari/537.36 OPR/53.0.2907.99" 188.163.109.153 - - [20/Dec/2019:06:43:05 +0900] "POST /cgi-bin/movabletype/mt-comments.cgi HTTP/1.0" 404 432 "http://www.ei.fukui-nct.ac.jp/%7Et-saitoh/exam/" "Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/66.0.3359.170 Safari/537.36 OPR/53.0.2907.99" 45.32.193.50 - - [20/Dec/2019:07:06:15 +0900] "GET /~t-saitoh/exam/apply-prog.html HTTP/1.0" 200 5317 "http://www.ei.fukui-nct.ac.jp/" "Mozilla/5.0 (Windows NT 5.2) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/63.0.3239.132 Safari/537.36"

- この結果を見ると mt-comments.cgi というアクセスが見つかる。どうも コメントスパム(ブログのコメント欄に広告を勝手に書き込む迷惑行為)をしようとしている。

ネットワーク攻撃への対処

今回の access.log のアクセス履歴解析は、Webサーバへのアクセスへの基本的な対処となる。しかし、もっと違うネットワーク接続ではどのような対処を行うべきであろうか?

一般的には、

- サーバにネットワークアクセスの記録ソフトを使う(例ネットワークプロトコルアナライザーWireShark)

- ファイアウォールのアクセス履歴を解析

授業内レポート

- ここまでのLOG解析の例の1つについて、どういう考え方でフィルタを使っているのか、自分の言葉で説明せよ。

- LOG 解析のためのコマンドを考え、その実行結果を示し、それから何が判るか説明せよ。

(例) 自分で考えたコマンドの実行結果をつけたうえで、「コメントスパムを何度も試す危ないアクセス元は〇〇である。」 - レポート提出先フォルダ ファイル名は、出席番号2桁-名前-レポート名.docx (ファイル形式は pdf などでも良い) とする。

リダイレクトとパイプ

Linux/unixを使う上で、キーボードでコマンドを入力しているが、こういうコマンドの管理を行うプログラムを shell と呼ぶ。shell には、色々なものがある(sh, csh, bash, zsh)が、広く使われている bash( born-again shell )について説明する。最初に、コマンドの入出力を組み合わせるために重要となるリダイレクトとパイプについて説明する。

標準入出力とリダイレクト

出力リダイレクト

C言語のプログラミングで、プログラムの実行結果をレポートに張り付ける時はどのように行っているだろうか?多くの人は、実行画面を PrintScreen でキャプチャした画像を張り付けているかもしれない。しかし、数十行にわたる結果であれば何度もキャプチャが必要となる。

そこで、今日の最初はリダイレクト機能について説明する。

“gcc ファイル.c” は、C言語のプログラムをコンパイルし、a.out という実行ファイルを生成する。”./a.out” にてプログラムを実行する。実行する命令に、“> ファイル名” と書くと、通常の出力画面(標準出力) をファイル名に記録してくれる。これを出力リダイレクトと呼ぶ。また、“>> ファイル名” と書くと、既存ファイルの後ろに追記してくれる。

guest00@nitfcei:~$ cat helloworld.c

#include <stdio.h>

int main() {

printf( "Hello World\n" ) ;

return 0 ;

}

guest00@nitfcei:~$ gcc helloworld.c

guest00@nitfcei:~$ ./a.out

Hello World

guest00@nitfcei:~$ ./a.out > helloworld.txt

guest00@nitfcei:~$ cat helloworld.txt

Hello World

guest00@nitfcei:~$ ./a.out >> helloworld.txt

guest00@nitfcei:~$ cat helloworld.txt

Hello World

Hello World

入力リダイレクト

次に、1行に名前と3教科の点数が書いてある複数行に渡るデータの各人の平均点を求めるプログラムを考える。

guest00@nitfcei:~$ cp /home0/Challenge/2.1-RedirectPipe.d/avg-each-low.c .

guest00@nitfcei:~$ cat avg-each-low.c

#include <stdio.h>

// ((input)) ((output))

// saitoh 43 54 82 saitoh 59.67

// tomoko 89 100 32 tomoko 73.67

// mitsuki 79 68 93 mitsuki 80.00

int main() {

char name[ 100 ] ;

int point[ 3 ] ;

while( scanf( "%s%d%d%d" ,

name , &point[0] , &point[1] , &point[2] ) == 4 ) {

double sum = 0.0 ;

for( int i = 0 ; i < 3 ; i++ )

sum += point[i] ;

printf( "%s %6.2f\n" , name , sum / 3.0 ) ;

}

return 0 ;

}

guest00@nitfcei:~$ gcc avg-each-low.c

guest00@nitfcei:~$ ./a.out

saitoh 43 54 82 入力

saitoh 59.67 出力

tomoko 89 100 32 入力

tomoko 73.67 出力

^D ← Ctrl-D を押すとファイル入力を終了

しかし、プログラムの書き方を間違えてプログラムを修正していると、動作確認のたびに何度も同じデータを入力するかもしれないが、面倒ではないだろうか?

プログラムを実行する時に、“< ファイル名” をつけると、通常はキーボードから入力する所を、ファイルからの入力に切り替えて実行することができる。このようなscanf()を使う時のようなプログラムの入力を標準入力といい、それをファイルに切り替えることを入力リダイレクトと呼ぶ。

guest00@nitfcei:~$ cp /home0/Challenge/2.1-RedirectPipe.d/name-point3.txt . guest00@nitfcei:~$ cat name-point3.txt saitoh 43 54 82 tomoko 89 100 32 mitsuki 79 68 93 guest00@nitfcei:~$ ./a.out < name-point3.txt saitoh 59.67 tomoko 73.67 mitsuki 80.00

この入力リダイレクトと出力リダイレクトを合わせて使うこともできる。

guest00@nitfcei:~$ ./a.out < name-point3.txt > name-avg.txt guest00@nitfcei:~$ cat name-avg.txt saitoh 59.67 tomoko 73.67 mitsuki 80.00

パイプ

先の名前と3教科のプログラムの結果から、全員の平均点をも計算したい場合、どのようなプログラムを作るだろうか?C言語だけの知識なら、各人の行のデータを計算するループの中に、全員の合計と人数を求めるプログラムを書いて、最後に平均点を出力するだろう。

一方で、複数人の名前と平均点のデータから平均点を求めるプログラムを書いて、前述のプログラムの実行結果を使う人もいるだろう。

以下の例では、“gcc -o avg-each-row avg-each-row.c” で、avg-each-row という実行ファイル、“gcc -o avg-all avg-all.c” で、avg-all という実行ファイルを生成し、avg-each-row で入力リダイレクト・出力リダイレクトを使って、name-avg.txt を作り、avg-all を入力リダイレクトで、最終結果を表示している。

guest00@nitfcei:~$ cp /home0/Challenge/2.1-RedirectPipe.d/avg-all.c .

guest00@nitfcei:~$ cat avg-all.c

#include <stdio.h>

// ((input)) ((output))

// saitoh 59.67 73.11

// tomoko 73.67

// mitsuki 80.00

int main() {

char name[ 100 ] ;

double point ;

double sum = 0 ;

int count = 0 ;

while( scanf( "%s%lf" , name , &point ) == 2 ) {

sum += point ;

count++ ;

}

printf( "%6.2f\n" , sum / (double)count ) ;

return 0 ;

}

guest00@nitfcei:~$ gcc -o avg-each-low avg-each-low.c

guest00@nitfcei:~$ gcc -o avg-all avg-all.c

guest00@nitfcei:~$ ./avg-each-low < name-point3.txt > name-avg.txt

guest00@nitfcei:~$ ./avg-all < name-avg.txt

71.11

しかし、いちいち入出力の結果を name-avg.txt を作るのは面倒である。であれば、以下の様なイメージで処理をすれば答えが求まる。

name-point3.txt→(avg-each-row)→name-avg.txt→(avg-all)→結果

これは、パイプ機能を使って以下の様に動かすことができる。

guest00@nitfcei:~$ ./avg-each-low < name-point3.txt | ./avg-all 71.11 guest00@nitfcei:~$ cat name-point3.txt | ./avg-each-low | ./avg-all 71.11

プログラムを実行する時に、“A | B” ように書くと、プログラムA の標準出力結果を、プログラムB の標準入力に接続させて、2つのプログラムを実行できる。このような機能を、パイプと呼ぶ。上記例の2つめ “cat… | ./avg-each-low | ./avg-all” では3つのプログラムをパイプでつないでいる。

リダイレクトのまとめ

| 入力リダイレクト(標準入力) | 実行コマンド < 入力ファイル |

| 出力リダイレクト(標準出力) | 実行コマンド > 出力ファイル |

| 出力リダイレクト(標準出力の追記) | 実行コマンド >> 出力ファイル |

| 標準エラー出力のリダイレクト | 実行コマンド 2> 出力ファイル |

| パイプ コマンドAの標準出力をコマンドBの標準入力に接続 |

コマンドA | コマンドB |

標準エラー出力,/dev/null, /dev/zero デバイス

パイプやリダイレクトを使っていると、出力をファイルに保存する場合、途中で異常を伝える目的で出力メッセージを出力するものが見逃すかもしれない。こういった際に、計算結果などを出力する標準出力(stdout)とは別に標準エラー出力(stderr)がある。ファイルを使う際には、デバイスを区別するためのデバイス番号(ファイルディスクリプタ)を使う。この際に、標準入力(stdin) = 0, 標準出力(stdout) = 1, 標準エラー出力(stderr) = 2 という番号を使うことになっている。

#include <stdio.h>

int main() {

int x , y ;

scanf( "%d%d" , &x , &y ) ;

if ( y == 0 )

fprintf( stderr , "zero divide\n" ) ;

else

printf( "%f\n" , (double)x / (double)y ) ;

}

Unix のシステムでは、特殊なデバイスとして、/dev/null, /dev/zero というのがある。

/dev/null は、入力リダイレクトに使うと ファイルサイズ 0 byte のデータが得られるし、出力リダイレクトに使うと 書き込んだデータは捨てられる。 /dev/zero は、入力リダイレクトに使うと、’\0′ のデータを延々と取り出すことができ、ファイルをゼロで埋めるなどの用途で使う。

/dev/null の使い方の例としては、例えば標準エラー出力が不要なときは、コマンドラインで以下のようにすれば、標準エラー出力(デバイス番号2番)の内容を捨てることができる。

$ command 2> /dev/null

C言語のコンパイルまとめ

| C言語のコンパイル(実行ファイルはa.out) | gcc ソースファイル |

| 実行ファイル名を指定してコンパイル | gcc -o 実行ファイル ソースファイル |

理解度確認

Windows における PRN デバイス, AUX デバイス

/dev/null といった特殊デバイスの一例として、昔の Windows では PRN デバイス、AUX デバイスというのがあった。

C:< command > PRN昔の文字印刷しかできないプリンタが普通だったころは、PRN という特殊デバイスがあって、このデバイスにリダイレクトをすれば、出力をプリンタに出力することができた。同じように AUX というデバイスは、通信ポートにつながっていて ” command > AUX ” と入力すれば、通信先にデータを送ることができた。最近のプリンタや通信デバイスはもっと複雑になっているためにこういった機能は使えなくなっているが、このデバイス名の名残りで、Windows では PRN とか AUX という名前のファイルを作ることはできない。

Webプログラミングとセキュリティ

ここまでの授業では、Webを使った情報公開で使われる、HTML , JavaScirpt , PHP , SQL などの解説を行ってきたが、これらを組み合わせたシステムを構築する場合には、セキュリティについても配慮が必要である。

今回は、初心者向けの情報セキュリティの講習で使われるCTFという競技の練習問題をつかって、ここまで説明してきた Web の仕組みを使ったセキュリティの問題について解説を行う。

バックエンドと所有権の設定

前回の講義でファイルのパーミッション(読み書き権限)について確認したが、バックエンドプログラミングで必要となるファイルの所有権の設定を通して、演習を行う。これに合わせ、サーバ上のファイルの編集作業なども体験する。

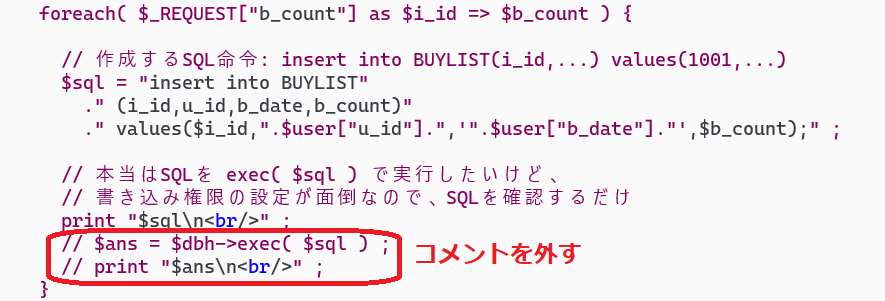

サーバ上のファイルの編集

以前のバックエンドのプログラムの演習ではサーバの設定などの体験もできていないため、フロントエンドの処理でサーバ上に送られたデータは、最終的な書き込み処理は行っていなかった。今回は、サーバ上でデータをサーバ上のバックエンドプログラムの PHP ファイルを修正し、データが書き込めるようにプログラムの修正を行う。

サーバ上のファイルを編集するには、色々な方法がある。

- サーバ上のエディタで直接編集

- unix のシステムで直接ファイルを編集するのであれば、vim や emacs を利用するのが一般的であろう。これらのエディタはリモートサーバにsshなどでログインしている時は、端末ソフトの文字表示機能だけで動作し、GUI 機能を使わない。vim や emacs は、古くから使われ、Windows で動く vim や emacs もある。

- システム管理者権限で編集する必要があるファイルの場合は、以下に紹介するような方法は煩雑であり、サーバ上で直接編集も知っておくべき。

- プログラムをローカルPCで編集しアップロード(今回はコレ)

- 前回の演習では、リモートサーバに接続する際には ssh コマンドを用いたが、ssh にはファイル転送のための scp コマンドも用意されている。

- scp コマンドは、通常の cp 命令 ( cp コピー元 コピー先 ) を ssh のプロトコルでリモートする機能を拡張したものであり、リモートのコンピュータをコピー元やコピー先として指定する場合は、 ユーザ名@リモートホスト:ファイル場所 と記載する。

-

# remotehostのファイル helloworld.c をローカルホストのカレントディレクトリ.にダウンロード C:\Users\tsaitoh> scp tsaitoh@remotehost:helloworld.c . # ローカルホストの foobar.php を remotehostの/home/tsaitoh/public_html/ フォルダにアップロード C:\Users\tsaitoh> scp foobar.php tsaitoh@remotehost:/home/tsaitoh/public_html/

- VSCode でリモートファイルを編集

- 最近のエディタでは、前述のローカルPCで編集しアップロードといった作業を、自動的に行う機能が利用できる。emacs の tramp-mode や、VS Code の Remote ssh プラグインなどがこれにあたる。利用する演習用のサーバが高機能であれば、vscode + remote-ssh が一番便利と思われるが、remote-ssh はサーバで大きな node.js を動かすため、サーバ負担が大きいので今回はこの方式は使わない。

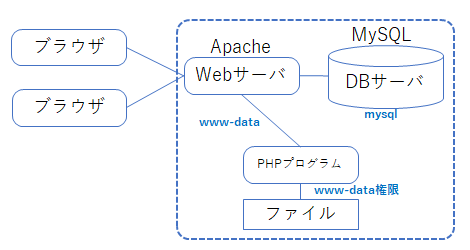

Webアプリと所有権の問題

PHPで書かれたバックエンドでのプログラムにおいて、Webサーバは www-data(uid),www-data(groupid) というユーザ権限で動作している。そして、webサーバと連動して動く PHP のプログラムも www-data の権限で動作する。一方で、通常ユーザが開発しているプログラムが置かれる $HOME/public_html フォルダは、何もしなければそのユーザのものである。このため、PHP のプログラムがユーザのフォルダ内にアクセスする際には、www-data に対してのアクセス権限が必要となる。

Windows ユーザが Web プログラミングの体験をする際には、XAMPP などのパッケージを利用することも多いだろう。しかし XAMPP などは、中身のWebサーバ(apache), DBサーバ(MySQL)などすべてがインストールしたユーザ権限で動いたりするため、所有権の設定の知識が無くても簡単に利用することができる(あるいはユーザ自身が管理者権限を持っているため設定が無くてもアクセス権問題が発生しない)。このため Linux 環境での Web プログラミングに移行する際に、ユーザ権限の設定を忘れ、プログラムが動かず戸惑うことも多い。

今回の演習では、管理者権限で動いている自分のパソコンの中のXAMPPを使わず、複数のユーザで動いている演習用サーバを用いる。

データベースサーバの場合

また、データの保存でデータベースを利用する場合、Oracle や MySQL といった、ネットワーク型のデータベースでは、Webサーバとは別にデータベースのサーバプログラムが動作している。ネットワーク型のデータベースでは、様々なユーザ・アプリケーションがデータの読み書きを行うため、SQL の create user 命令でユーザを割り当て、grant 命令でユーザのデータへのアクセス権限を指定する。

Webアプリは、データベースのサーバに接続する際には、ユーザ名とパスワードが必要となる。

簡易データベースSQLiteの場合

簡単なデータベースシステムの SQLite は、PHP の SQLite プラグインを経由してディレクトリ内のファイルにアクセスする。このため、データベースファイルやデータベースのファイルが置かれているフォルダへのアクセス権限が必要となる。今回の演習用サーバでは、ゲストアカウントは www-data グループに所属しているので、データベースファイルやフォルダに対し、www-data グループへの書き込み権限を与える。

chown , chgrp , chmod コマンド

ファイル所有者やグループを変更する場合には、chown (change owner) 命令や chgrp (change group) 命令を使用する。ただし、chown はシステム管理者権限(root)でなければ使えない。chgrp も自分が所有してかつ変更後のグループに加入していなければ使えない。

chown ユーザID ファイル 例: $ chown tsaitoh helloworld.c chgrp グループID ファイル 例: $ chgrp www-data public_html

ファイルに対するパーミッション(利用権限)を変更するには、chmod (change mode) 命令を用いる。

chmod 命令では、読み書きの権限は2進数3桁の組み合わせで扱う。読書可 “rw-“ = 6, 読出可 = “r–“ = 4 , ディレクトリの読み書き可 “rwx” = 7 など。ファイルには、所有者,グループ,その他の3つに分けて、読み書きの権限を割り当てる。2進数3桁=8進数1桁で表現できることから、一般的なファイルの “rw-,r–,r–“ は、8進数3桁 で 644 , ディレクトリなら “rwx,r-x,r-x” は 755 といった値で表現する。

chmod 権限 ファイル

例: $ chmod 664 helloworld.c

$ ls -al

-rw-rw-r-- tsaitoh ei 123 5月20 12:34 helloworld.c

$ chmod 775 public_html

drwxrwxr-x tsaitoh www-data 4096 5月20 12:34 public_html

8進数表現を使わない場合

$ chmod u+w,g+w helloworld.c

ユーザ(u)への書き込み権限,グループ(g)への書き込み権限の追加(+)

$ chmod g-w,o-rw helloworld.c

グループ(g)書き込み権限を消す、その他(o)の読み書き権限を消す(-)

$ chmod u=rw,g=r,o=r helloworld.c

ユーザ(u)への読み書き,グループ(g),その他(o)への読み出し権限を設定(=)

演習内容

前回の演習と同じ方法でサーバにログインし、サーバ上で直接ファイル編集をしてみよう。

C:\Users\tsaitoh> ssh -P 443 guest00@nitfcei.mydns.jp $ ls -al -rw-r--r-- 1 guest00 root 76 Mar 8 12:06 helloworld.c $ vi helloworld.c もしくは $ emacs helloworld.c

- vim の使い方

- 挿入 iテキストESC

削除 x

ファイルの保存 :w

エディタの修了 ZZ

- emacs の使い方

- ファイルの保存 Ctrl-X Ctrl-S

エディタの修了 Ctrl-X Ctrl-C

GitHubから演習ファイルを複製

GitHub は、複数の開発者が共同でプログラムを開発するための環境で、プログラムの情報共有などに広く使われている。ファイルは、git コマンドで複製や更新ができる。

(( public_html の中に演習用ファイルを github からダウンロード )) $ cd ~/public_html public_html$ git clone https://github.com/tohrusaitoh/recp.git public_html/recp$ cd recp/ public_html/recp$ ls -al -rw-r--r-- 1 t-saitoh home 870 11月 10 2021 Makefile -rw-r--r-- 1 t-saitoh home 1152 10月 8 2021 README.md :

サーバ上のファイルをパソコンにコピーして編集

(( サーバ上のファイル sampleI.php (sample-アイ.php) をダウンロード )) C:\Users\tsaitoh> scp -P 443 guest00@nitfcei.mydns.jp:public_html/recp/sampleI.php . VSCode などのエディタで編集 (( 編集した sampleI.php をサーバにアップロード )) C:\Users\tsaitoh> scp -P 443 sampleI.php guest00@nitfcei.mydns.jp:public_html/recp/

Webサーバで書き込みができるように設定

(( public_html のデータベースファイル shopping.db を書き込み可能にする )) $ chgrp www-data ~guest00/public_html/recp/shopping.db $ chmod g+w ~guest00/public_html/recp/shopping.db (( public_html/recp フォルダを書き込み可能にする )) $ chgrp www-data ~guest00/public_html/recp $ chmod g+w ~guest00/public_html/recp

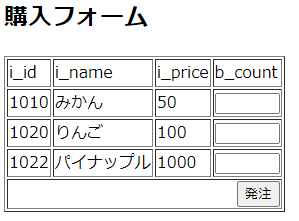

バックエンドプログラムを実行してみる

パソコンのブラウザで、http://nitfcei.mydns.jp/~guest00/recp/sampleI.php を開く。

書き込み結果を確認してみる

(( データベースファイル shopping.db の書込み結果を確認 )) $ cd ~guest00/public_html/recp public_html/recp$ sqlite3 shopping.db SQLite version 3.31.1 2020-01-27 19:55:54 Enter ".help" for usage hints. sqlite> select * from BUYLIST ; 1010|10001|2021-11-05|1 1020|10001|2021-11-05|2 1022|10001|2021-11-05|3 : sqlite> [Ctrl-D] コントロールDで sqlite3 を抜ける public_html/recp$

レポート課題(sampleI.phpの修正と動作確認)の提出先※ 作業のみでレポートはなし

unixにおけるファイルとユーザ管理

Unix演習サーバへの接続

Unix(Linux)は、インターネットでのサーバとして広く活用されている。Linuxを試すには、Windows ならば WSL や Cygwin であったり、Mac でも使える仮想OSの VMware, VirrtualBox を使うこともできる。今回の演習では、全員が同じ環境で使うために、クラウド環境にサーバを準備し利用する。

ネットワークの向こう側にあるサーバを利用する場合、以下のような方法が使われる。

- telnet (port 23)

- キー入力を相手に送って、送られてくるデータを画面に表示する。

- 通信データが暗号化されないので盗聴される心配があり、一般的には使用しない。

- rsh (remote shell – port 514)

- ネットワークを越えてコマンドを実行したりファイル転送ができる。

- telnet 同様に暗号化されていないので、次に示す ssh を使うのが一般的。

- ssh (secure shell – port 22)

- rsh の処理を暗号化しながら実行。

- ネットワークを越えた処理を行う際の基本だが、ssh を経由した攻撃が多いことから、通常のポート番号22以外を使ったり、アクセス制限を厳しく設定する必要がある。

- remote Desktop

- ネットワークの先のPCの画面をネットワーク越しに触れるようにしたもの。

教室のWiFi環境(fnct-student)では、HTTP(80) , HTTPS(443) の通信しか使えないことから、ssh(22) が通常利用できない。電子情報のWiFiアクセスポイント(nitfc-ei-student等)であれば、ssh などが使用できる。

今回授業の演習では、さくらインターネットのサーバ上のクラウドサーバを利用する。

ただし、さくらインターネットのクラウドサーバでは、ssh(port=22)が使用できるが、ssh 接続の際にログインパスワードの間違いなどが多発すると、ssh 経由の攻撃の可能性があると判断され、ssh(port=22)接続が一定時間使えなくなる対策がとられている。今回は、ゲストアカウントでパスワード入力ミスが多発することが想定されるので、port=22のsshは使用しない。

リモート接続を行う

Windows 10 or Windows 11 ならば、cmd.exe , macOS ならば、ターミナルソフトを起動し、以下の操作を行う。

$ ssh -p 443 ゲストID@演習サーバ

- 443ポートは通常は https 用だが、今回はサーバで ssh プロトコルを 443 ポートで受け付けるように設定してある。かなり特殊な使い方なので要注意。

- 演習サーバの接続方法(学内のみ) – サーバへの攻撃を極力へらすために非公開。

- 今回の演習では、センターIDではなくゲストIDを使います。

- ゲストIDのパスワードは、こちらのファイル(Teams)を参照。(2025-4EI Teams)

- パスワード入力時は、打つたびに●●●といった文字は表示されません。

- パスワード入力時にタイプミスした時は、Ctrl-U で最初から入力のやり直しができます。

ファイル操作の基本

まずは基本操作をしてみよう。ls コマンド(list) は、ディレクトリ内にあるファイルの一覧を表示する。cat コマンド(catalog)は、指定されたファイルの内容を表示する。

s53599xx@nitfcei:~$ ls

helloworld.c Maildir public_data public_html

s53599xx@nitfcei:~$ ls -l

total 8

-rw-r--r-- 1 s53599xx students 76 Dec 21 14:30 helloworld.c

drwx------ 5 s53599xx students 4096 Dec 21 14:30 Maildir

(略)

s53599xx@nitfcei:~$ cat helloworld.c

#include <stdio.h>

int main() {

printf( "Hello World\n" ) ;

return 0 ;

}

s53599xx@nitfcei:~$

ファイルをコピーするには cp コマンド(copy)、不要なファイルを消すには rm コマンド(remove)を使う。

s53599xx@nitfcei:~$ cp helloworld.c test.c s53599xx@nitfcei:~$ ls -l total 8 -rw-r--r-- 1 s53599xx students 76 Dec 21 14:30 helloworld.c drwx------ 5 s53599xx students 4096 Dec 21 14:30 Maildir -rw-r--r-- 1 s53599xx students 76 Dec 21 14:40 test.c (略) s53599xx@nitfcei:~$ rm test.c s53599xx@nitfcei:~$ ls -l total 8 -rw-r--r-- 1 s53599xx students 76 Dec 21 14:30 helloworld.c drwx------ 5 s53599xx students 4096 Dec 21 14:30 Maildir s53599xx@nitfcei:~$

ファイル詳細表示の説明

ls -l で表示される詳細の内容は以下の通り。

| 属性 | リンク数 | 所有者 | グループ | サイズ | 日付 | ファイル名 |

|---|---|---|---|---|---|---|

| – rw- r– r– | 1 | s53599xx | students | 76 | Dec 21 14:30 | helloworld.c |

| d rwx — — | 5 | s53599xx | students | 4096 | Dec 21 14:30 | Maildir |

| – | d | -: 通常ファイル, d:ディレクトリ | ||||

| rw- | r,w,x | 所有者が r:読み出し, w:書き込み, -: 権限なし ファイルなら、x:実行可能 ディレクトリなら、x:ディレクトリに入れる |

||||

| r – – | – – – | グループの rwx の属性 r– は 読み込みだけ許可 | ||||

| r – – | – – – | その他の rwx の属性 — は、読み書き禁止 | ||||

基本的なファイル操作コマンド一覧

| 操作 | Linux | Windows |

|---|---|---|

| ディレクトリ一覧(list) ディレクトリ詳細 |

ls 場所 ※ ls -l 場所 |

dir /w 場所 ※ dir 場所 |

| ※ 省略時はカレントディレクトリ | ||

| ファイル表示(catalog) | cat 場所 | type 場所 |

| ファイルコピー(copy) | cp コピー元 コピー先 cp コピー元 コピー先ディレクトリ |

copy コピー元 コピー先 |

| ファイル削除(remove) | rm 場所 | del 場所 |

| ディレクトリ作成(make dir) | mkdir 場所 | md 場所 |

| ディレクトリ削除(remove dir) | rmdir 場所 | rmdir 場所 |

| カレントディレクトリ移動 (change directory) |

cd 場所 | cd 場所 ドライブの場合は ドライブ名: |

| 所有者を変更(change owner) | chown 所有者 場所 | |

| グループを変更(change group) | chgrp グループ 場所 | |

| 属性を変更(change mode) | chmod 属性 場所 | ←属性の書き方 |

ワイルドカード文字

ls などのコマンドで、複数のファイルを対象とするとき、ワイルドカード文字が使える。

| 任意の1文字 ? |

(例) $ ls # 全部のファイル aaa.c ab.c abc.c bcd.c defgh.c hij.cxx $ ls a?.c # aで始まる2文字のC言語ファイル ab.c $ ls ???.c # 3文字のC言語のファイル aaa.c abc.c bcd.c |

| 任意の文字 * |

(例) $ ls a*.c # aで始まるC言語ファイル aaa.c ab.c abc.c $ ls *.cxx # 拡張子が.cxxのファイル(C++) hij.cxx |

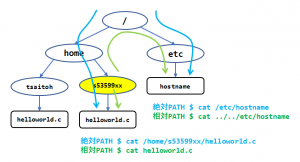

相対PATHと絶対PATH

ファイルの場所を指定するには、2つの方法がある。

絶対PATHは、木構造の根(ルートディレクトリ / で表す) からの経路のディレクトリ名を”/”で区切って書き連ねる。ルートディレクトリからの場所であることを示すために、先頭を / で始める。住所を /福井県/越前市/宮谷町/斉藤家 と書くようなもの。

相対PATHは、現在注目しているディレクトリ(カレントディレクトリと呼ぶ)からの経路を書く。住所でいうと、/福井県/越前市 に注目している状態で、宮谷町/斉藤家 と書くようなもの。

ただし、/福井県/福井市 に注目している状態で、片町/山本家 は1つのファイルでも、/福井県/福井市/片町/山本家 とは別に /石川県/金沢市/片町/山本家 があるかもしれない。

上記の絵であれば、/home/tsaitoh/helloworld.c を、相対PATHで書く場合、s53599xx の一つ上にさかのぼって場所を指定することもできる。一つ上のディレクトリ(親ディレクトリ)は .. (ピリオド2つ)

上記の絵であれば、/home/tsaitoh/helloworld.c を、相対PATHで書く場合、s53599xx の一つ上にさかのぼって場所を指定することもできる。一つ上のディレクトリ(親ディレクトリ)は .. (ピリオド2つ)

この場合、” $ cat ../tsaitoh/helloworld.c ” の様な相対PATHでもアクセスできる。

カレントディレクトリ自身を表す場合は、. (ピリオド1つ)を使う。

/home/s53599xx/helloworld.c の場所は、” $ cat ./helloworld.c ” と書くこともできる。

ユーザとグループ

unixでは、ユーザとグループでアクセス制限をすることができる。ユーザ情報は、/etc/passwd ファイルで確認できる。グループ情報は、/etc/group ファイルで確認できる。

$ more /etc/passwd root:x:0:0:root:/root:/bin/bash daemon:x:1:1:daemon:/usr/sbin:/usr/sbin/nologin bin:x:2:2:bin:/bin:/usr/sbin/nologin (略) guest00:x:1200:1200:guest00,,,:/home0/guests/guest00:/bin/bash $ more /etc/group root:x:0: daemon:x:1: bin:x:2: (略) guests:x:1200:guest00,guest01,guest02,...

| /etc/passwd | /etc/group |

| guest00 — ユーザID x — 昔は暗号化されたパスワード 1200 — ユーザID番号 1200 — グループID番号(/etc/groupを参照) guest00,,, — ユーザの正式名や電話番号など /home0/guests/guest00 — ホームディレクトリ /bin/bash — 使用する shell |

guests — グループID x — 昔は暗号化されたグループパスワード 1200 — グループID番号 guest00,guest01,guest02 — 所属するユーザ一覧 |

アクセス制限の実験

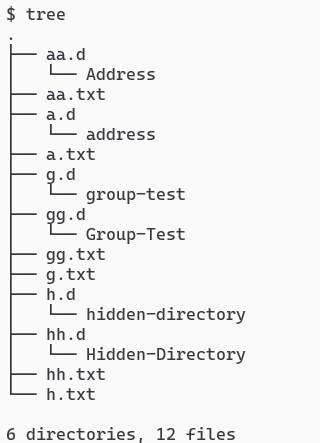

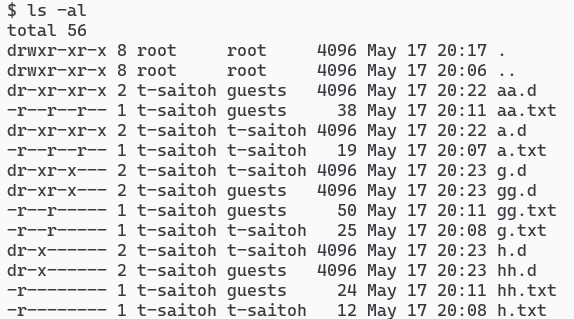

/home0/Challenge/AccesControl に、いくつかのファイルが保存してあり、t-saitoh が見ると、以下のようなファイルであった。tree コマンドでは、いくつかのディレクトリとその中のファイルが確認できる。しかし、ls -al にてファイルのアクセス権限が確認できる。tree コマンドで確認できるファイルにアクセスすると何が起こるか確認すること。

$ cd /home0/Challenge/AccessControl $ id # 自分のID,グループを確認 uid=1200(guest00) gid=1200(guests) groups=1200(guests) $ tree # ディレクトリ構造を表示 $ ls -al # 権限情報を表示 |

|

|

|

Windows とアクセスコントロール

Unix のシステムでは、ファイル毎に、ユーザID,グループIDを割り当て、ユーザ, グループ, その他に対して、Read, Write などの制限をかける。Windows では、さらに細かくアクセス制限を加えることができる。Windows では、1つのファイルに対して、ユーザやグループのRead/Writeなどの制限をいくつでも設定できる。Access Control List と呼ばれる。

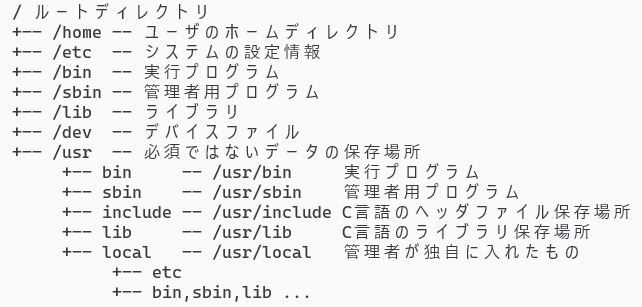

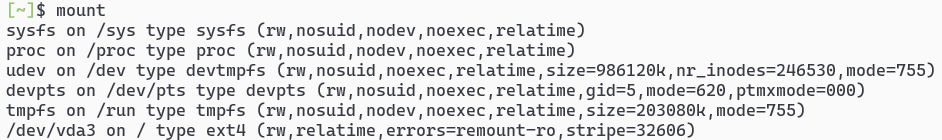

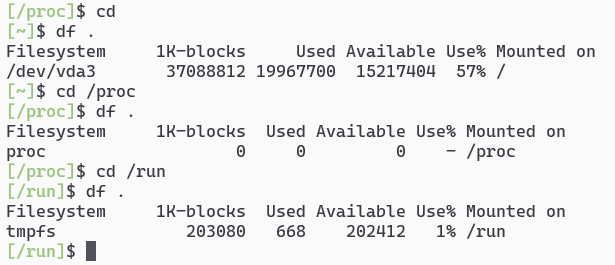

主要なディレクトリとファイルシステム

unix では、すべてのデバイスを / (ルートディレクトリ) 配下に木構造につなげて管理している。CD-ROM や USB ディスクなどは、指定したディレクトリに mount (マウント) して使用する。

ext4 は、Linux で採用されているファイルシステムで、システムの保存に使われる。

tmpfs は、主記憶(D-RAM) の一部を、ディスクと同じように扱えるようにしたファイルシステム。通称 ram disk(ラムディスク)。保存はメモリへのアクセスなので、保存やアクセスは極めて高速だが、保存領域は少ない。高速に扱えて、システムが再起動された時に消えても問題のない情報を保存するために使われる。

proc は、実行中のプロセス情報を、ハードディスクに保存されたファイルの様に参照できる。

vfat , exfat は、USBメモリ, SDカード のデータ保存で使われるファイルシステムで、Windows(MS-DOS) で使われている保存形式。ファイルにファイル所有者などの概念がない。

ntfs は、Windows で使われているファイル形式。

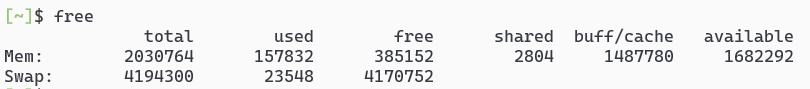

swap は、仮想メモリのためのデータが保存される。主記憶メモリが不足した際に、使用頻度の少ないメモリ領域をハードディスクに保存するための領域。以下のような free コマンドで使用状況が確認できる。一般的に、主記憶メモリの数倍を割り当てる。

PHPとデータベースによるバックエンドプログラミング

前回の講義では、Webページの作り方として、JavaScriptを用いたブラウザで動くプログラミングについて説明を行った。今回の授業では、データを管理しているサーバ側(バックエンド)で使われるプログラミング言語 PHP についての紹介と、データを管理するためのプログラム言語 SQL について説明し、簡単な演習をレポート課題とする。

前回授業の未解説部分

- JavaScriptを用いたフロントエンド

- Webの公開からWebサービスの公開へ

- 2025/情報メディア工学(4/30) Formsによる小テスト

PHPとデータベースによるバックエンドプログラミング

- PHPとデータベースによるバックエンドプログラミング

- 以下のサンプル(sampleD.php~) PHP のファイルなので、ダウンロードしたファイルを開いてもこのままでは動きません。動作確認のページにて実行結果を確認してください。

- PHPによるHelloWorld

- PHPによるデータの受け取り

- データベースとは

- sampleG-itemlist.sql

- sampleG-userlist.sql

- sampleG-buylist.sql

- Paiza.io の itemlist,userlist,buylist の動作確認ページ – このページにてSQLの練習問題を答えてください

- PHPの中でSQLを使う

- 05/12 SQL練習問題のレポート提出先はこちら

JavaScriptによるフロントエンドとPHPバックエンド入門

前回の講義では、インターネットの仕組みを復習し、そこで使われるプログラミング言語などを紹介した。

今回の授業では、インターネットのブラウザ側(フロントエンド)で使われるプログラム言語である JavaScript の基本について整理しなおし、簡単な穴埋め問題による演習を行う。

JavaScriptによるフロントエンドプログラミング

-

- 以下のサンプル(sample3.html~sampleA.html)は、各HTMLファイルを開くとソースコードが表示されます。JavaScriptによるプログラムなので、自分のパソコンにダウンロードし、演習についてはダウンロードしたファイルを編集して、ブラウザで動作を確認してください。

- sample3.html

- sample4.html

- sample5.html

- sample6.html — 簡単な穴埋め問題

- sample7.html

- sample8.html

- sample9.html — 簡単な穴埋め問題

- sampleA.html

- sampleA.css

- 以下のサンプル(sampleB2.html~sampleC2.html)は、jquery が html ファイルと同じ場所に置いてある必要があり、ダウンロードしたファイルを開いてもこのままでは動きません。動作確認のページにて実行結果を確認してください。

- sampleB2.html 動作確認Webページ

- sampleC2.html 動作確認Webページ

- sampleC.json

- 無名関数の説明

- 練習問題 6 , 9 の提出先

- 2024/情報メディア工学(4/24)小テスト

インターネットとWebの仕組み

前回の講義では、最初のガイダンスとしてOSの仕組みについて説明をおこなった。

2回目の授業では、インターネットのWebページを作るために使われているHTMLやCSSやプログラム言語について解説を行う。

Webページの生成とプログラム言語

理解確認

- こちらの小テストに回答してください。